Próbkowanie danych oraz mocno ograniczone raporty ze szczegółami dotyczącymi indeksacji to główne wyzwania w pracy z Google Search Console. Ograniczone dane możemy znacznie poszerzyć, korzystając z kilku narzędzi. Dowiedz się, jak wyciągnąć dokładniejsze dane z GSC przy pomocy GSC API, BigQuery, Looker Studio oraz Screaming Froga.

Spis treści:

- Stan indeksacji z Google Search Console + Screaming Frog

- Dane z Google Search Console + Looker Studio

- Google Search Console API + własne skrypty w Pythonie

- Google Search Console + BigQuery

Jak połączyć API Google Search Console ze Screaming Frogiem?

Jeśli nie masz dostępu do licencjonowanej wersji Screaming Froga, nic straconego. Dokładnie te same informacje wyciągnąć możesz przez API GSC, co pokazuję w dalszej części artykułu.

Jeżeli chcemy sprawdzić indeksowalność większej liczby adresów URL na naszej stronie, najwygodniejszym sposobem jest połączenie Screaming Froga z API Google Search Console. Oprócz weryfikowania standardowych danych crawler może wyciągnąć dzięki temu także dane o ruchu oraz dokonać inspekcji konkretnych adresów pod kątem ich indeksowalności.

Screaming Frog połączony z API Google Search Console pozwala uzyskać następujące informacje na temat wskazanych adresów URL:

- kliknięcia,

- wyświetlenia,

- CTR,

- średnia pozycja,

- status adresu URL w indeksie,

- data ostatniego crawla googlebota,

- typ user agenta tegoż crawla,

- ewentualne zablokowanie w robots.txt,

- status sukcesu w pobraniu strony,

- ewentualny noindex,

- canonical deklarowany przez stronę,

- canonical wybrany przez Google,

- status użyteczności mobilnej,

- status AMP,

- status rich results.

Niestety, URL Inspection API (dostarcza ono wszystkie dane związane z indeksem) ma ograniczenie do 2000 adresów URL dziennie. W samym GSC dostajemy jednak w konkretnych raportach maksymalnie 1000 URL-i, a także jesteśmy skazani na adresy wybrane przez system.

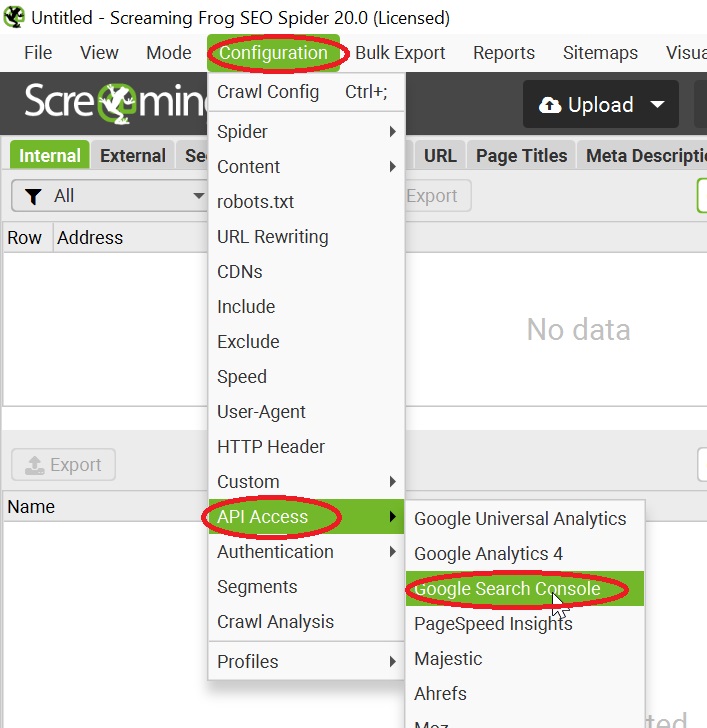

Aby połączyć Screaming Frog z Google Search Console API, musimy wykonać następujące kroki:

- Uruchomić Screaming Froga.

- W zakładce "Configuration" rozwinąć opcję "API Access" i wybrać "Google Search Console".

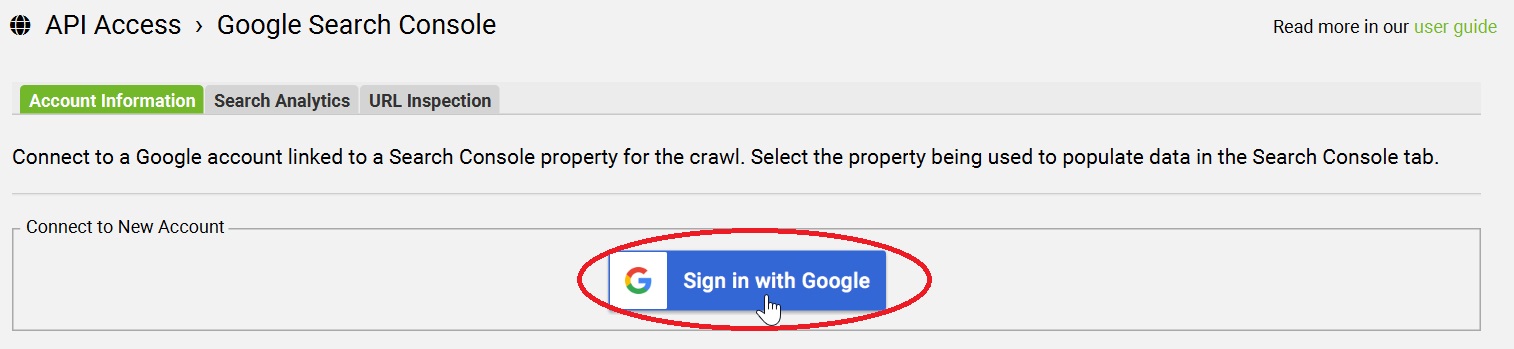

- W okienku, które wyskoczy, kliknąć przycisk "Sign in with Google".

- Pozwolić na autoryzację w ramach wybranego konta Google.

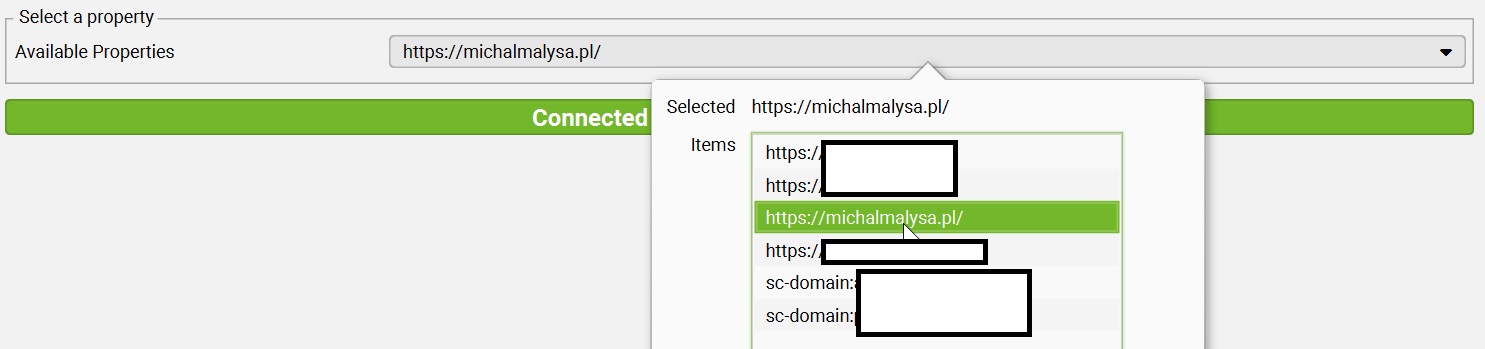

- Wybrać odpowiednią usługę GSC.

- Puścić crawl po całej stronie czy katalogu (opcja "Include" w zakładce "Configuration") albo wybranej liście adresów.

- Wyeksportować wyniki do Excela.

Jeżeli zależy nam na regularnych raportach, możemy ustawić harmonogram crawli, a dane pobierać automatycznie do Looker Studio. Popularne narzędzie do wizualizacji danych łączy się jednak GSC również bez pośrednictwa Screaming Froga. A przy tym, w przeciwieństwie do SC, nie wymaga wykupowania licencji.

Jak zaimportować dokładniejsze dane z Google Search Console do Looker Studio?

Próbkowanie danych w Google Search Console sprawia, że w przypadku stron przekraczających kilkaset tysięcy kliknięć miesięcznie umykać może nam nawet 30-40% ruchu (w artykule ze strony Similiar.ai pada nawet znacznie większy odsetek, sięgający 66% w przypadku wyświetleń).

Dane z raportu "Skuteczność" nie są zatem najlepszym źródłem wiedzy. Zdecydowanie nie powinno się opierać na nich strategicznych estymacji czy wyznaczać przy ich pomocy szczegółowych celów. Przez próbkowanie mogą również zaburzać prowadzone przez nas eksperymenty, które mają wykazać sensowność tych czy innych działań SEO.

Prostym sposobem na uzyskiwanie znacznie dokładniejszych danych jest połączenie Looker Studio z danymi Google Search Console przy użyciu wbudowanego w LS łącznika. O ile standardowe raporty z GSC mają objętość ograniczoną do 1000 wierszy, w przypadku LS możliwości zwiększają się nawet kilku czy kilkunastokrotnie.

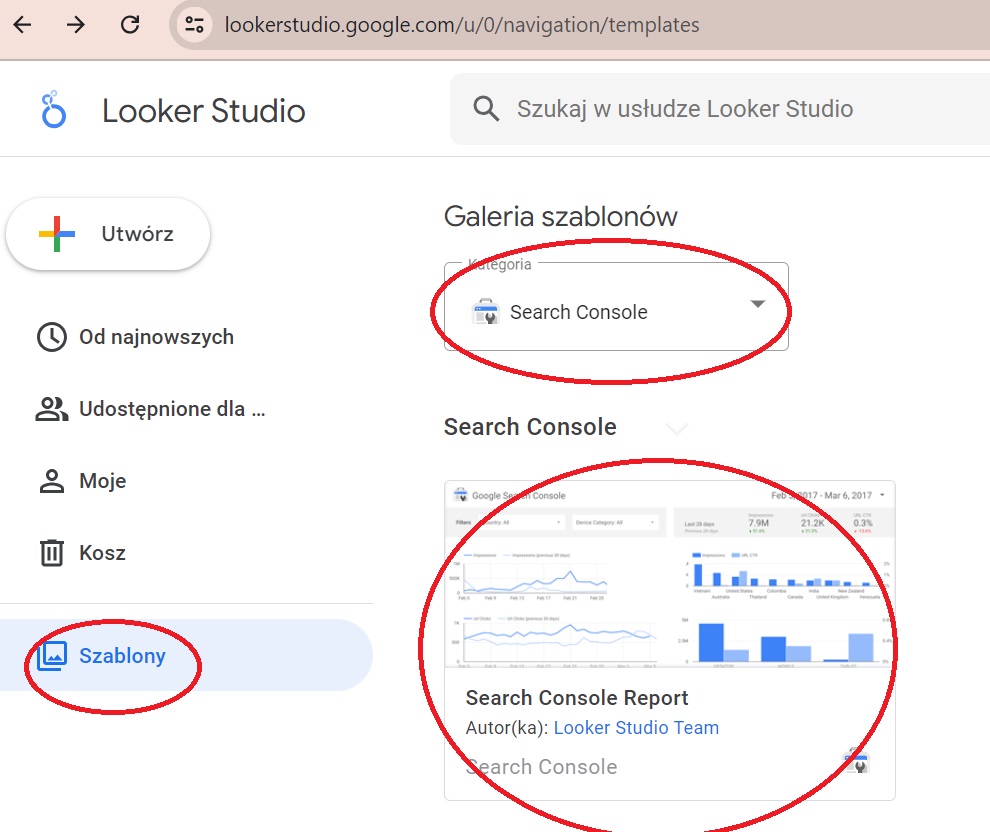

Aby połączyć te dwa narzędzia Google, należy:

- Wejść w zakładkę "Szablony" w Looker Studio.

- Wybrać kategorię "Search Console" i kliknąć szablon raportu.

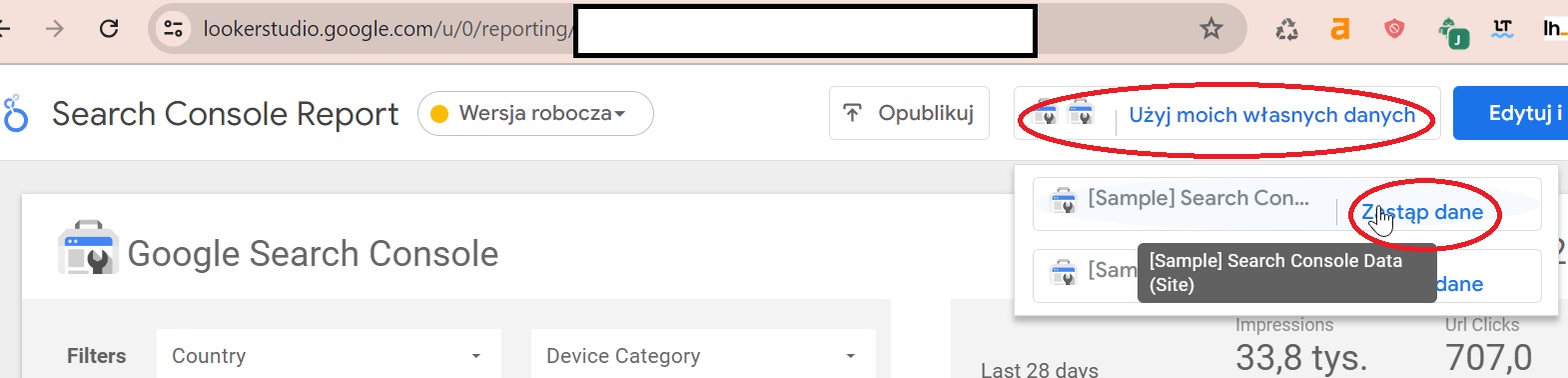

- W szablonie wybrać opcję "Użyj moich własnych danych".

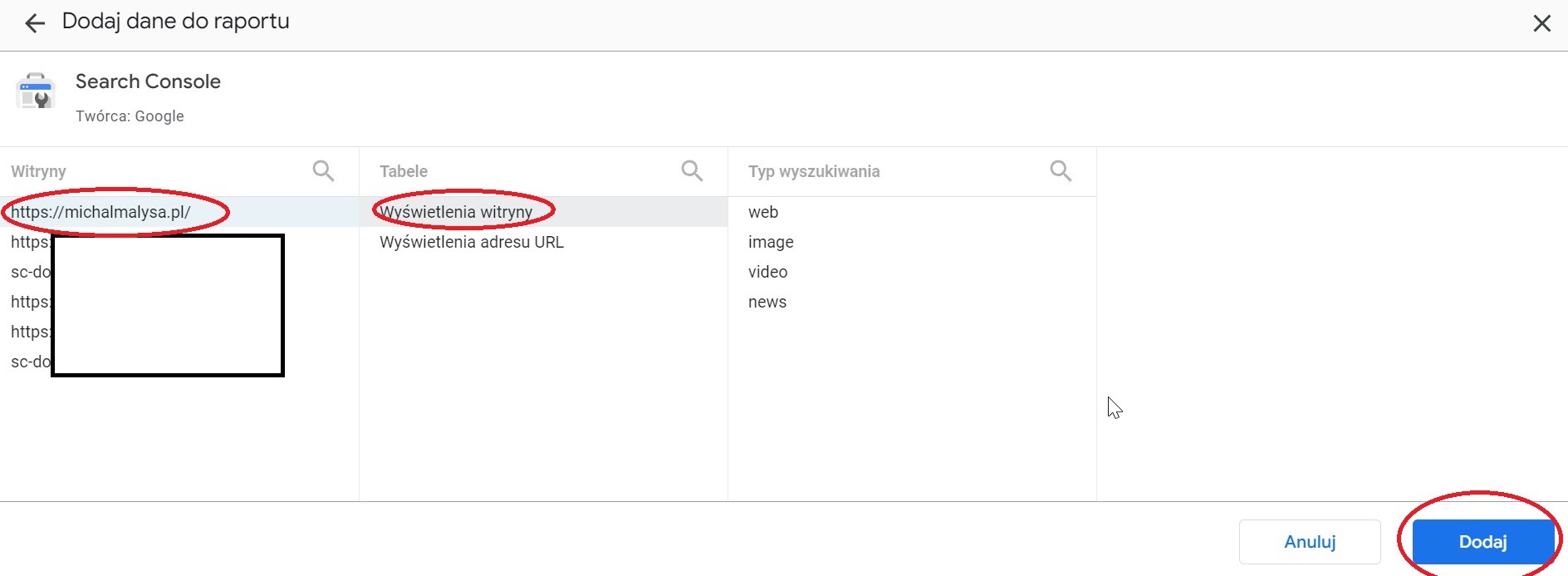

- Autoryzujemy połączenie z naszym kontem w GSC i wybieramy dwie wersje danych: dla Site będą to "Wyświetlenia witryny", zaś dla URL "Wyświetlenia adresu URL".

- Wybieramy interesujące nas daty, filtry i cieszymy się ze znacznie większej liczby danych niż w raportach skuteczności w Google Search Console.

Jest to najbardziej podstawowy raport, który wykorzystać możemy jako punkt wyjściowy. Looker Studio oferuje jednak znacznie szersze możliwości, przy czym tworzenie własnych dashboardów nie jest koniecznie. Warto wesprzeć się efektami pracy specjalistek i specjalistów SEO z całego świata. Szczególnie zainteresować mogą was następujące raporty:

- Latest Ranking Shifts Dashboard by Aleyda Solis

- Search Console Explorer Studio by Hannah Rampton

- SEOSLY Google Looker Studio SEO Template by Olga Zarr

Skrypty w Pythonie do komunikacji z API GSC

Umiejętność łączenia się z API Google Search Console bez użycia narzędzi przydaje się, jeżeli nie mamy dostępu do pełnej wersji Screaming Froga (taka opcja nie jest dostępna w wersji darmowej bez licencji) lub jeżeli chcemy skorzystać z opcji niedostępnych za pośrednictwem Looker Studio czy BigQuery, a więc wykraczających poza wyciąganie danych dotyczących widoczności.

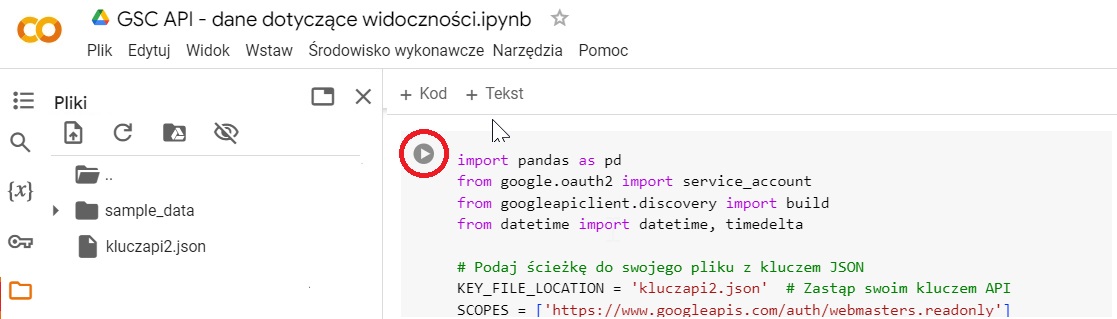

We wszystkich tych zadaniach wesprze nas Google Colab, za którego pośrednictwem odpalimy skrypt w Pythonie przystosowany do naszych potrzeb przez ChatGPT.

Ustawianie dostępu do GSC API w Google Cloud

Dla osób, które nie miały jeszcze do czynienia z Google Cloud, największym wyzwaniem może być uzyskanie danych autoryzacyjnych. Po kilkukrotnym przeklikaniu się przez usługę chmurową Google'a nie stanowi to problemu, ale pierwsze logowanie tam może być przytłaczające.

Aby uzyskać dostęp do GSC API w Google Cloud, należy:

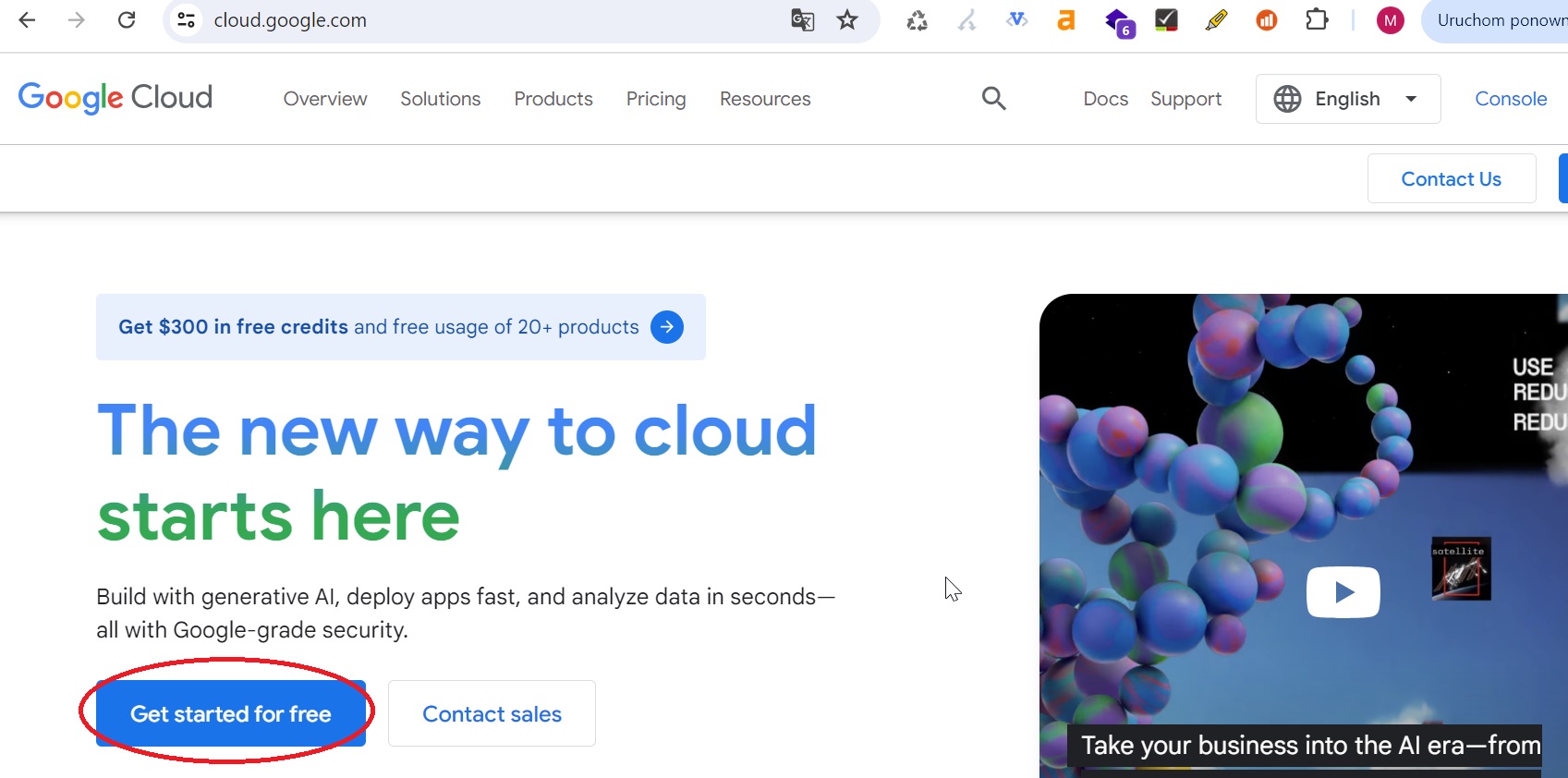

- Wejść do usługi Google Cloud.

- Kliknąć "Get started for free" i przejść proces rejestracji.

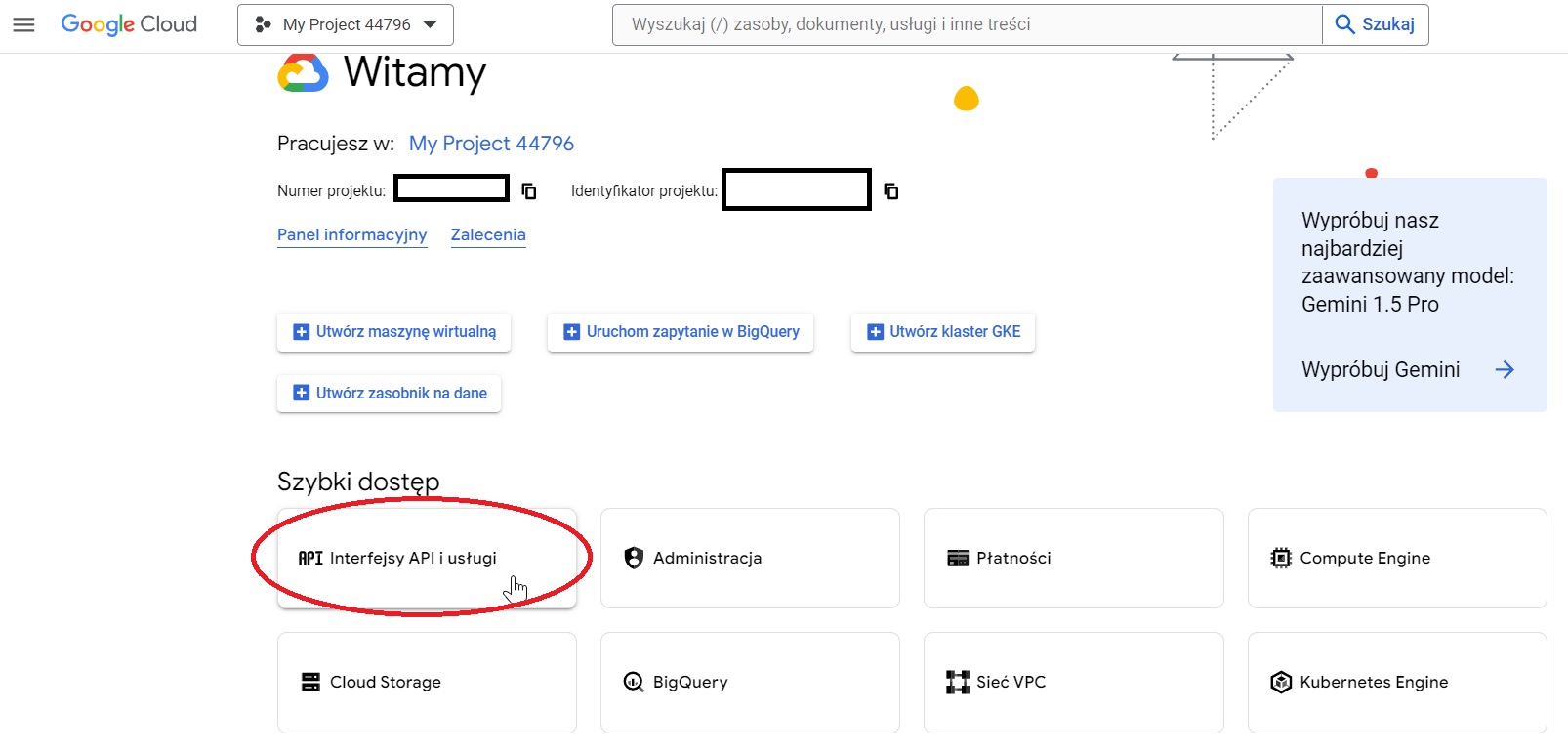

- Wejść w konsolę Google Cloud i utworzyć nowy projekt.

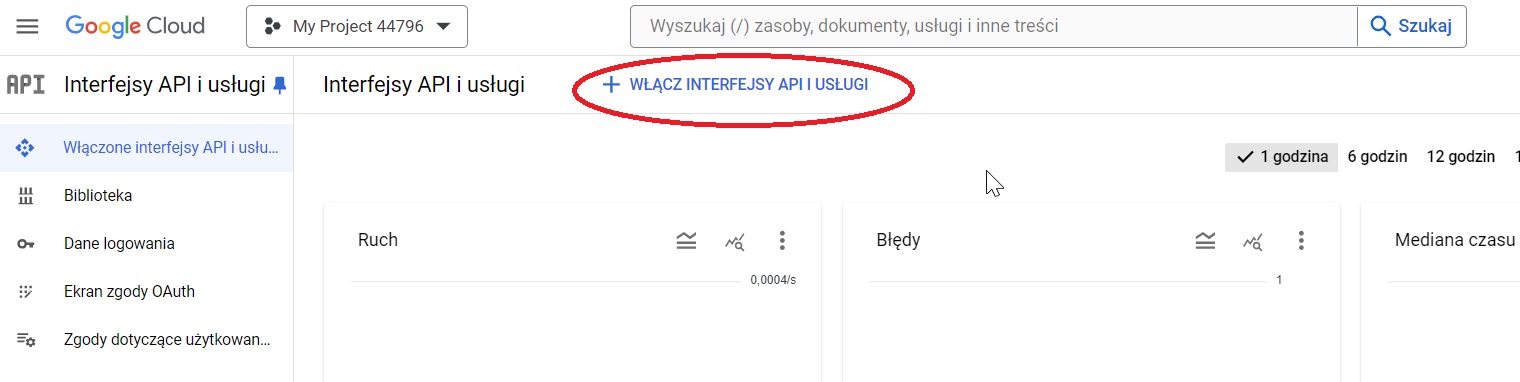

- W panelu projektu wybrać "Interfejsy API i usługi".

- Wybrać opcję "Włącz interfejsy API i usługi".

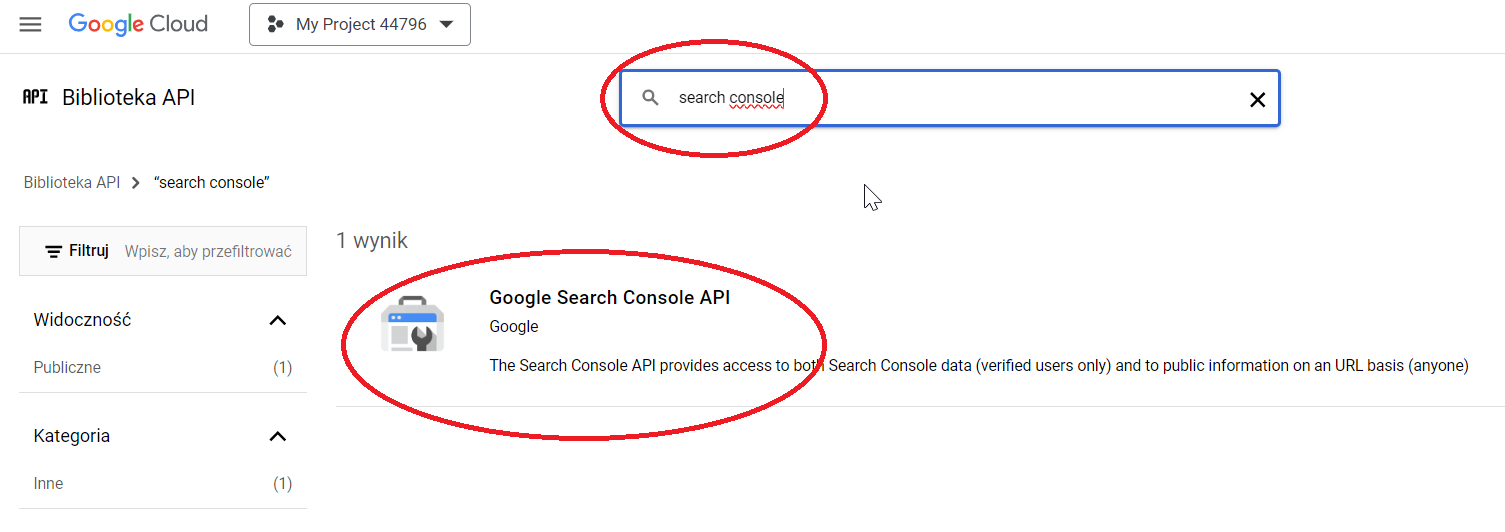

- Wyszukać usługę Google Search Console API i kliknąć w nią.

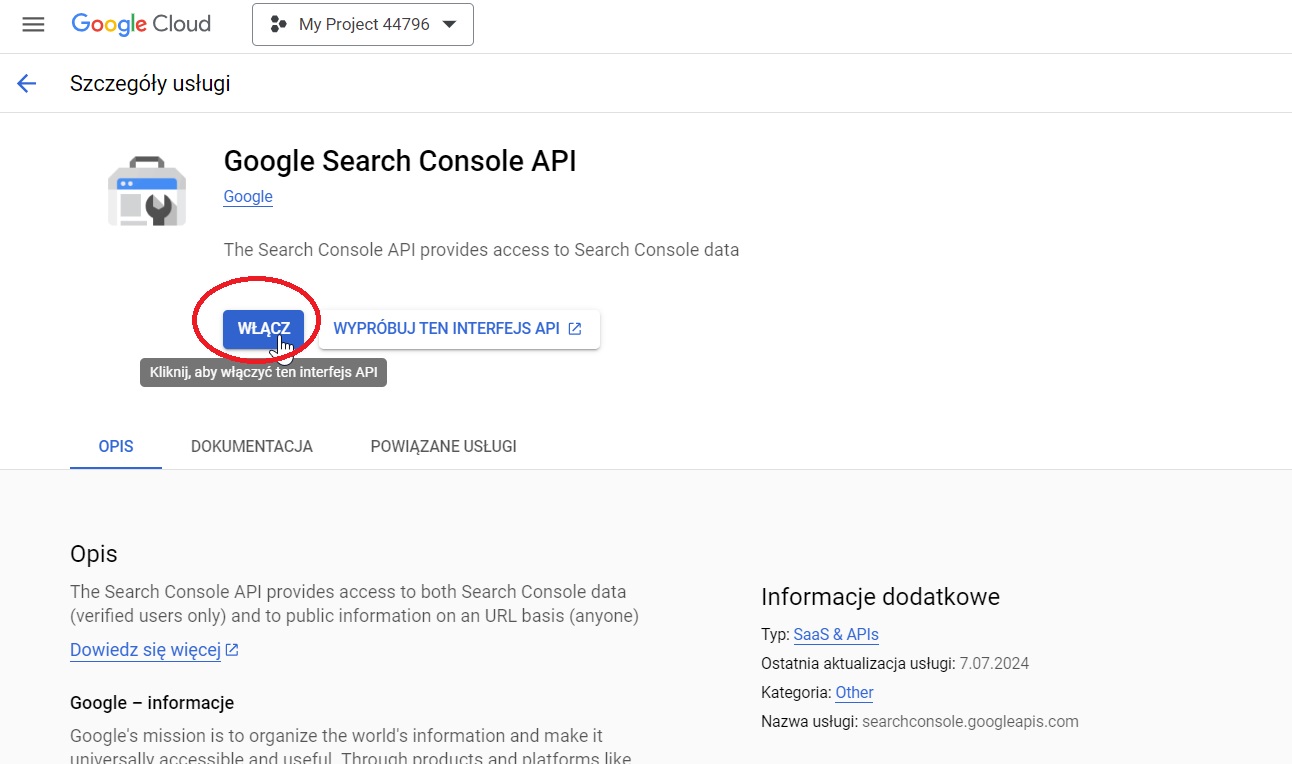

- Włączyć usługę GSC API.

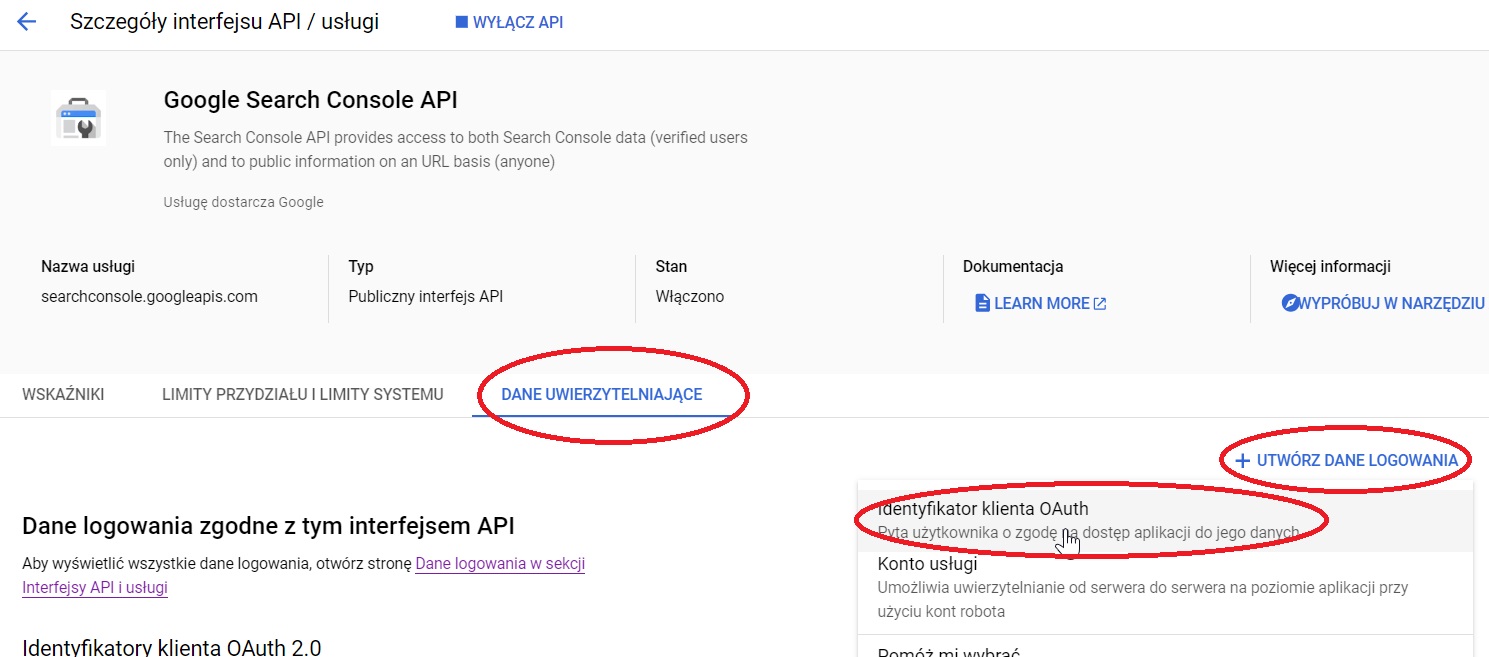

- Wybrać zakładkę "Dane uwierzytelniające" i po rozwinięciu opcji "Utwórz dane logowania" wybrać "Identyfikator klienta OAuth".

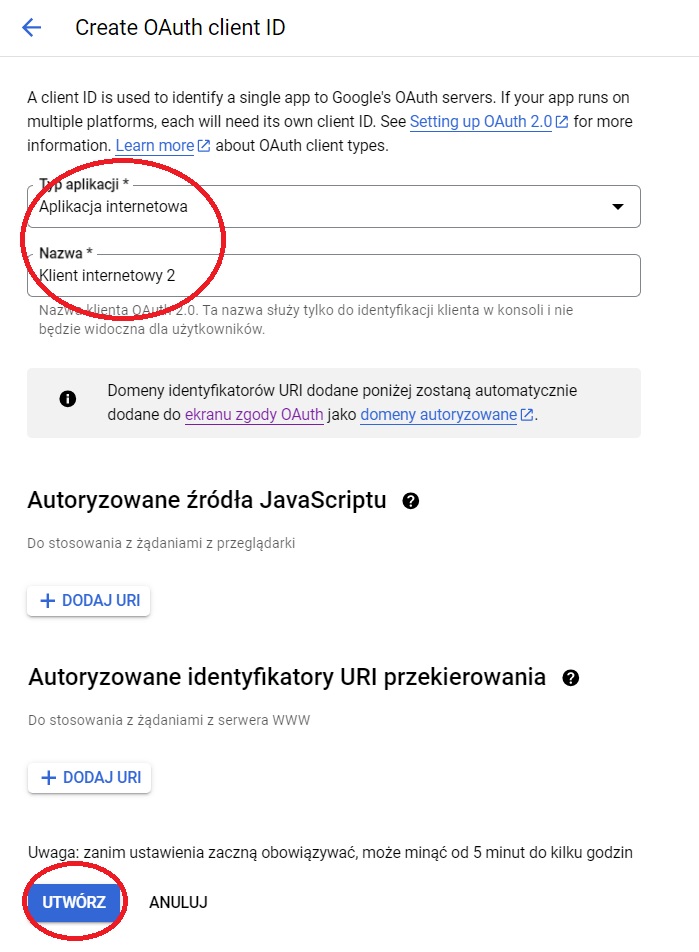

- Wybrać wartości dla "Typ aplikacji" oraz "Nazwa" i kliknąć "Utwórz".

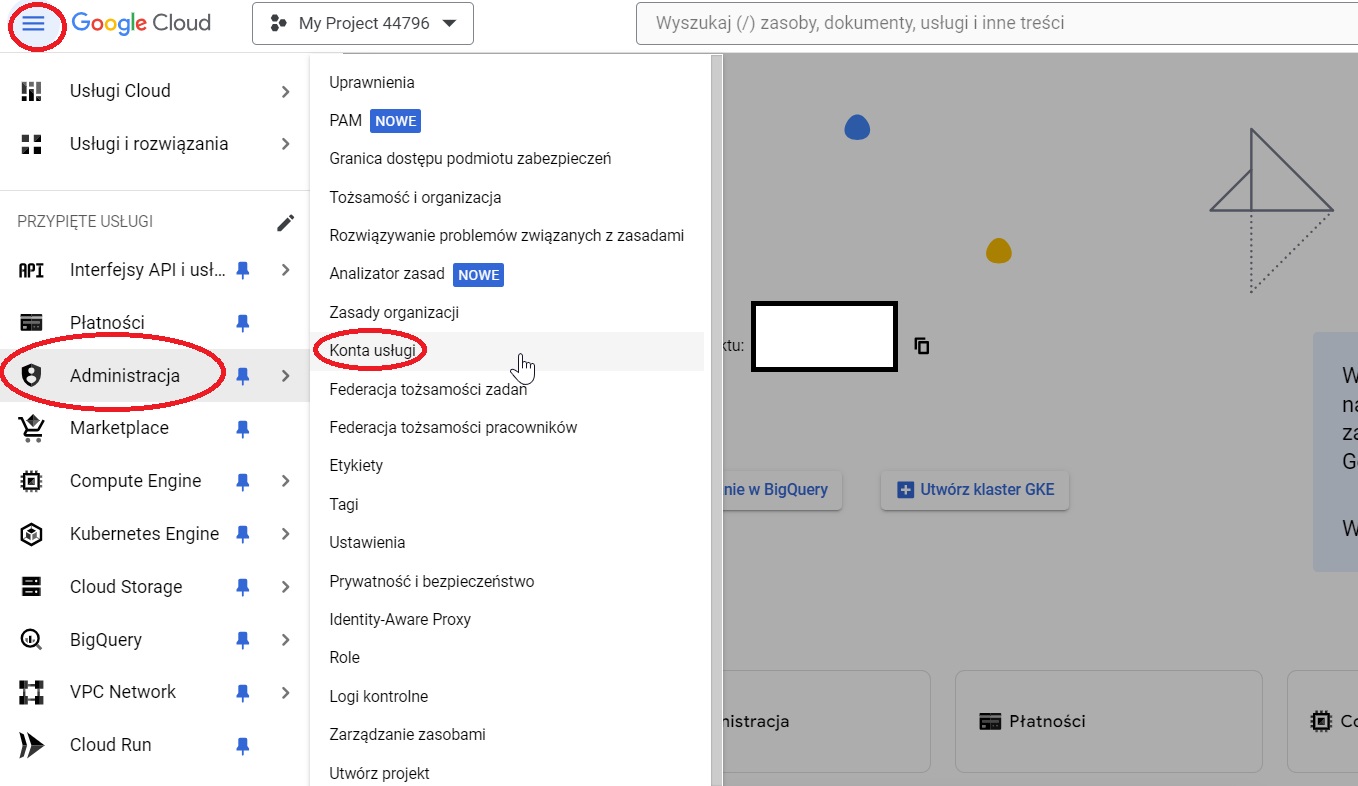

- W panelu projektu kliknąć hamburger z ustawieniami, tam rozwinąć zakładkę "Administracja" i kliknąć "Konta usługi".

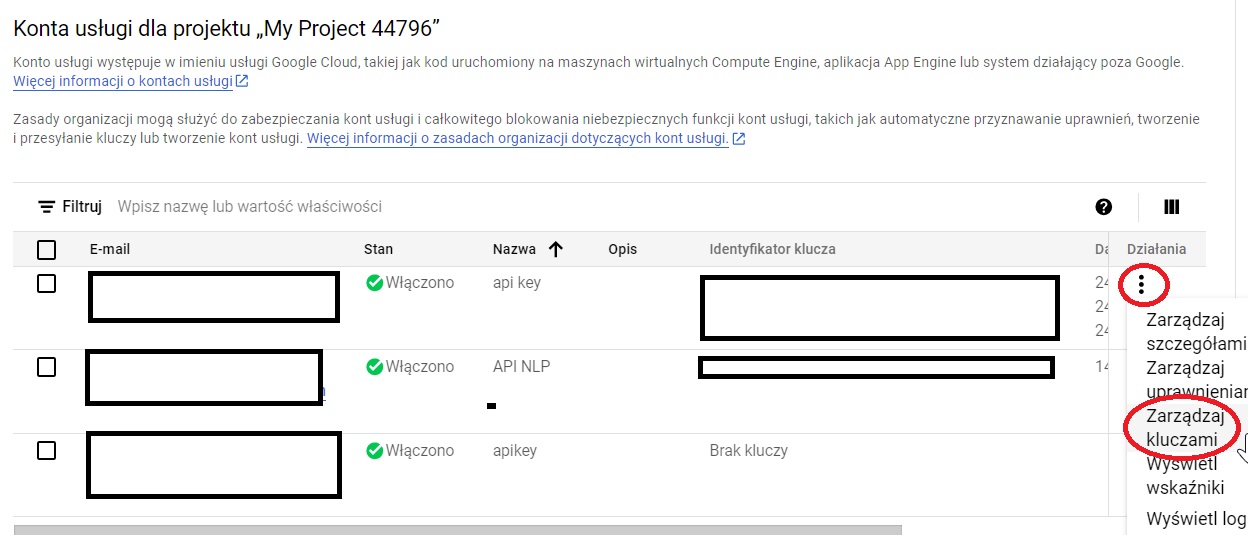

- W panelu "Konta usługi" rozwinąć trzy kropeczki z kolumny "Działania" i kliknąć "Zarządzaj kluczami".

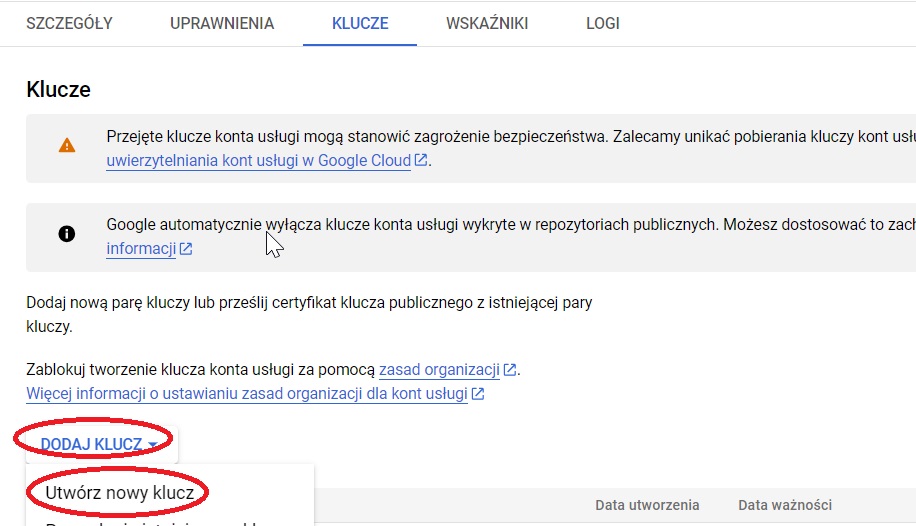

- W panelu zarządzania kluczami rozwinąć opcję "Dodaj klucz" i kliknąć "Utwórz nowy klucz".

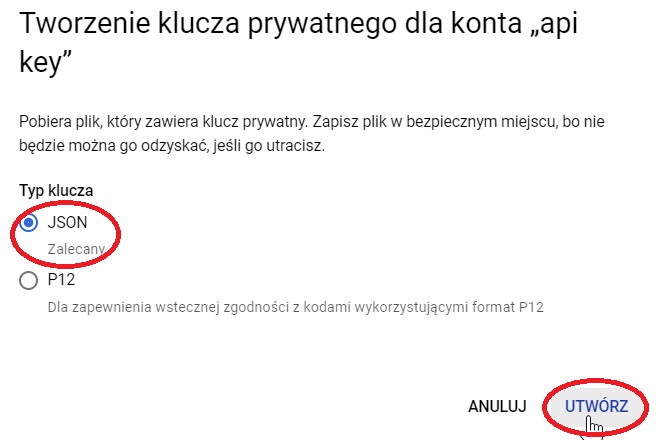

- W okienku, które wyskoczy, wybrać opcję "JSON" i kliknąć "Utwórz".

- Zapisać klucz pod zrozumiałą nazwą (np. "kluczapi").

- Otworzyć pobrany plik w notatniku i skopiować adres e-mail z parametru "client_email".

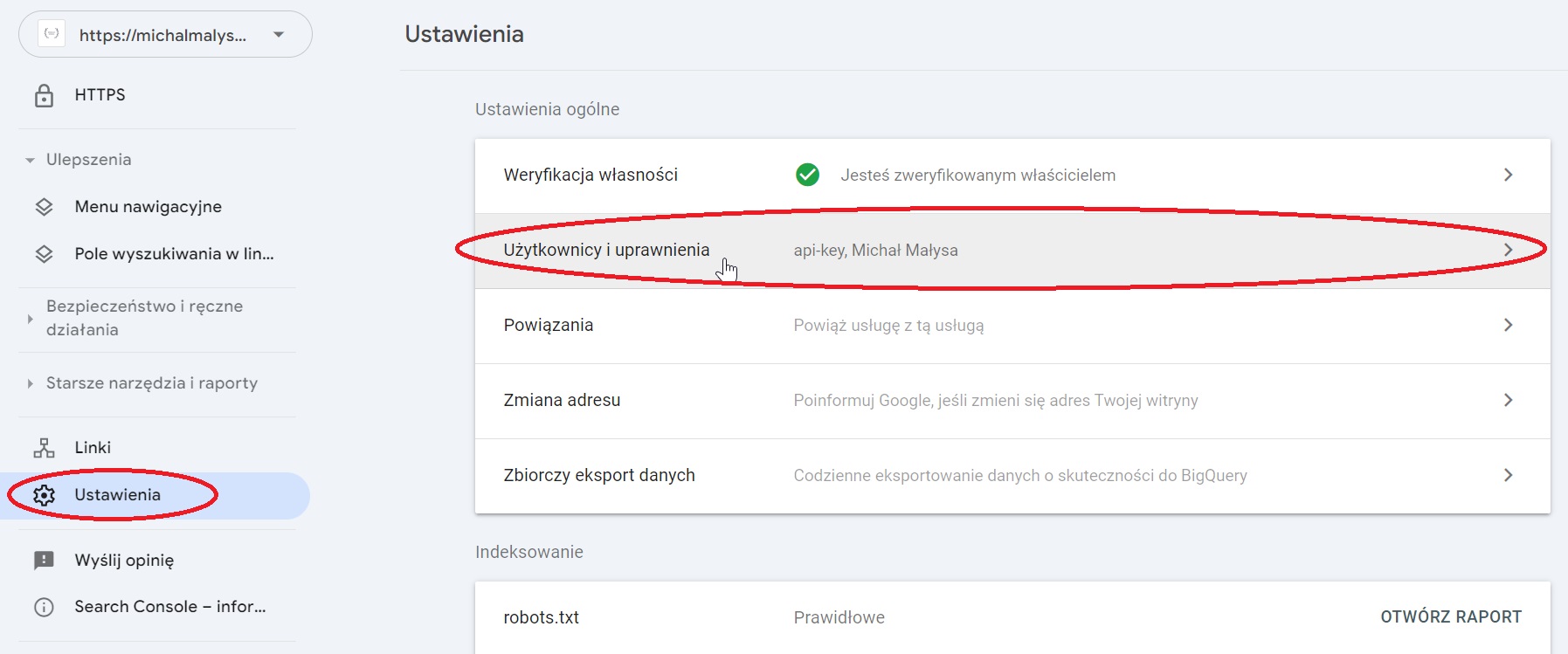

- W Google Search Console domeny, którą chcemy sprawdzać, wybrać "Ustawienia" i przejść do widoku "Użytkownicy i uprawnienia".

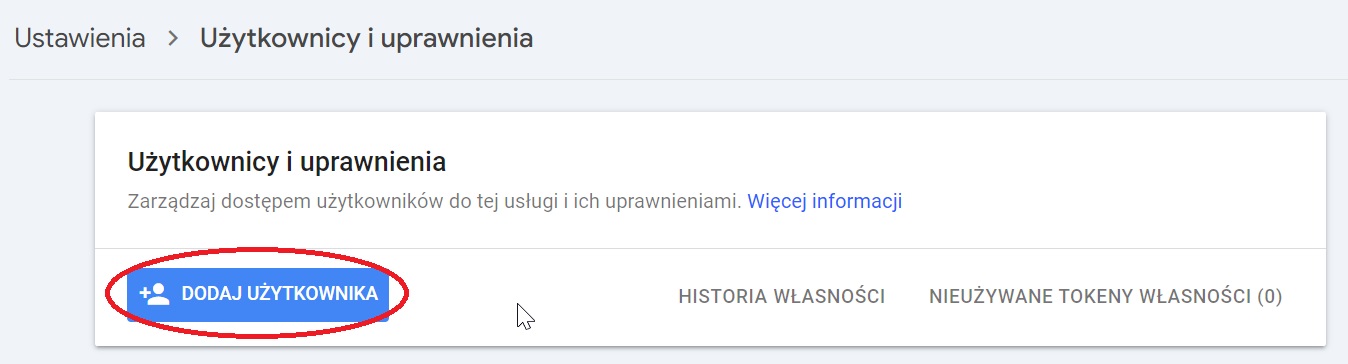

- W panelu "Użytkownicy i uprawnienia" kliknąć "Dodaj użytkownika".

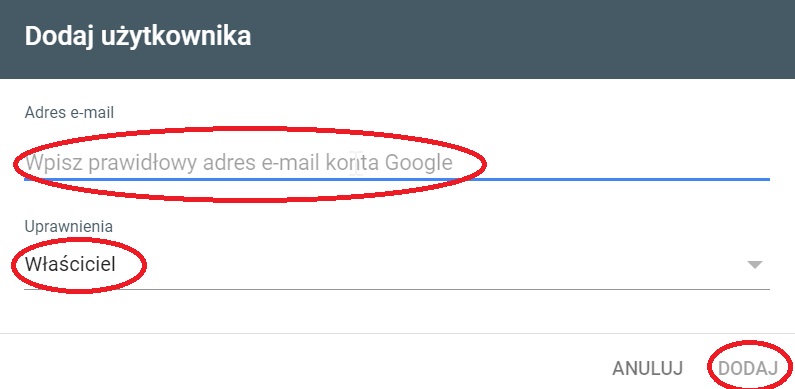

- W następnym okienku wkleić adres e-mail z klucza API, wybrać uprawnienia "Właściciel" i kliknąć "Dodaj".

Teraz możemy korzystać już z API GSC przy użyciu wygenerowanego w Google Cloud klucza API.

Sprawdzanie stanu zaindeksowania adresów URL przez GSC API

Działanie, które wcześniej pokazywałem z szybkim sposobem ze Screaming Froga, możliwe jest również do wykonania poprzez API GSC. Wadą tej drogi jest nieco większe skomplikowanie (związane z koniecznością napisania skryptu, co odbębniłem za was), ale zaletą jest bezpłatny charakter - nie trzeba mieć wykupionej licencji do SC.

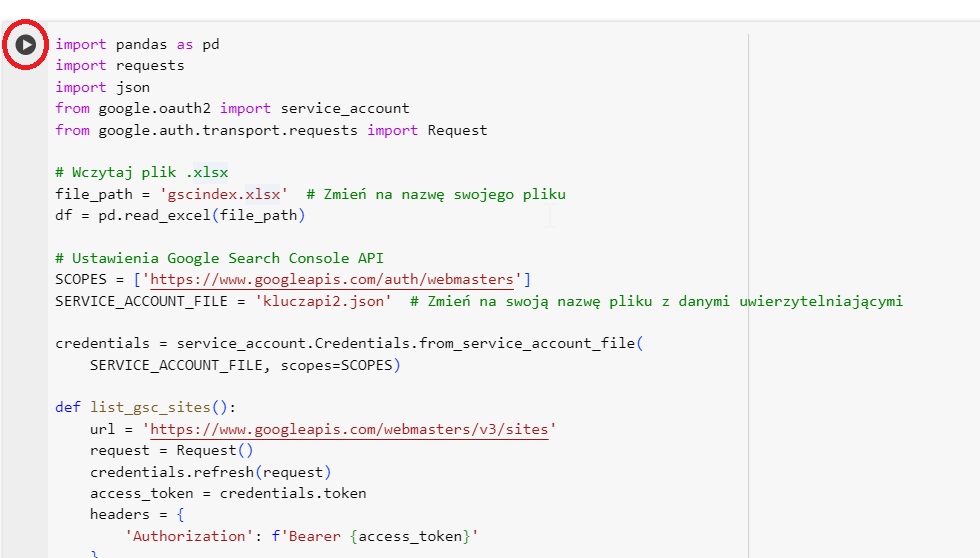

Aby sprawdzić stan zaindeksowania adresów URL w GSC API, należy:

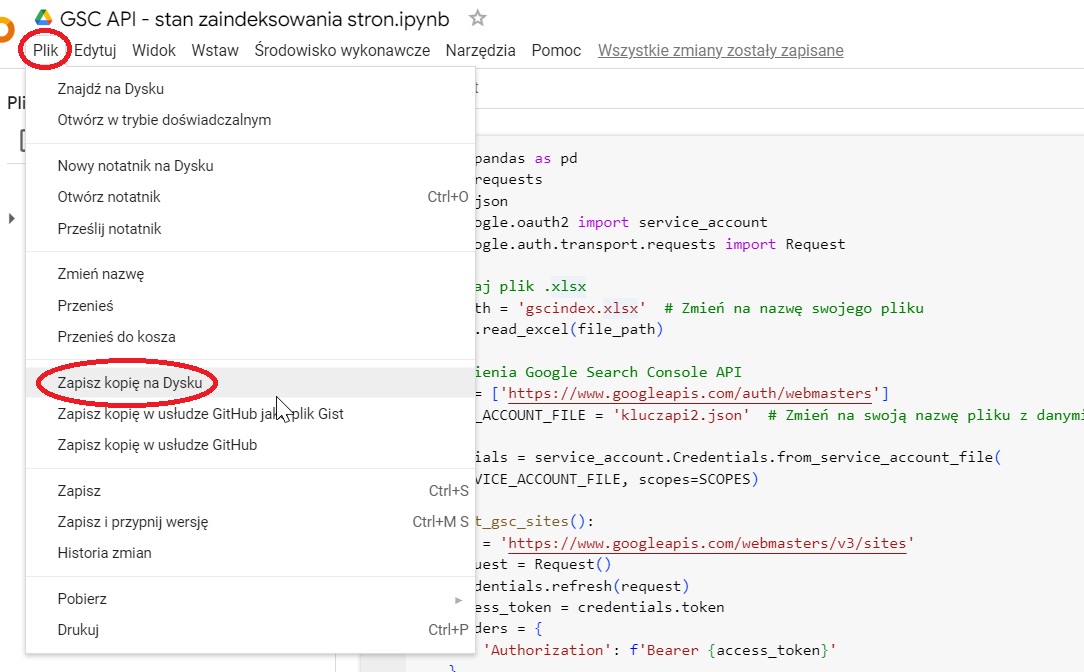

- Skopiować skrypt do sprawdzania stanu zaindeksowania adresów URL w GSC API na własny Dysk Google.

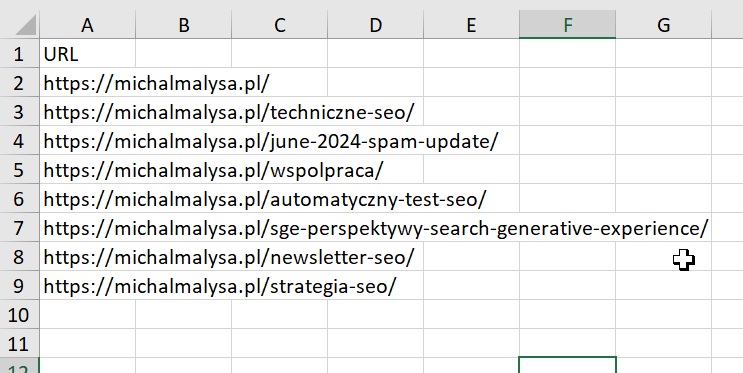

- Przygotować listę sprawdzanych adresów URL w pliku .xlsx.

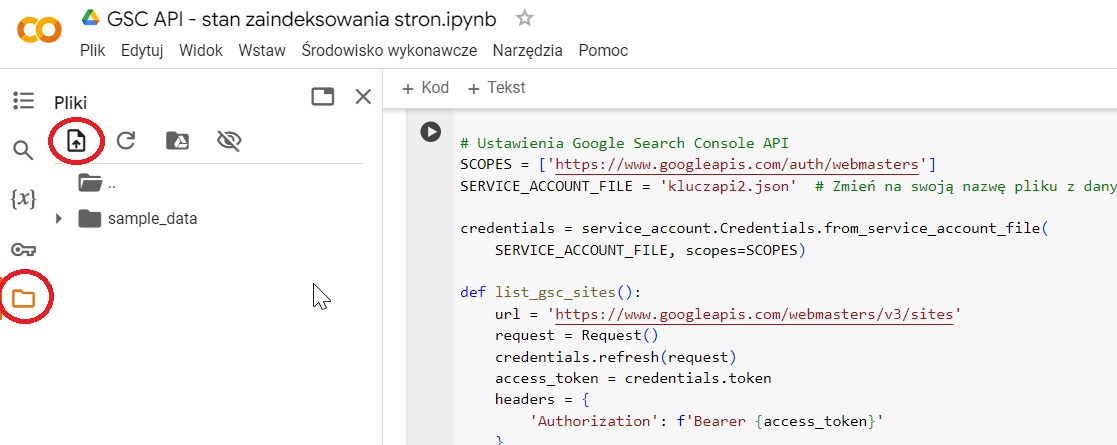

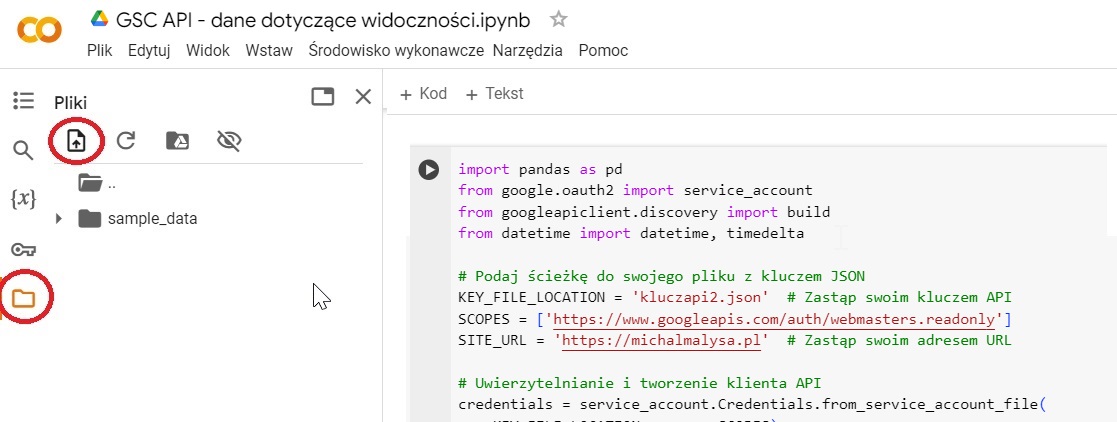

- Do pamięci wirtualnej wgrać klucz API oraz listę adresów URL.

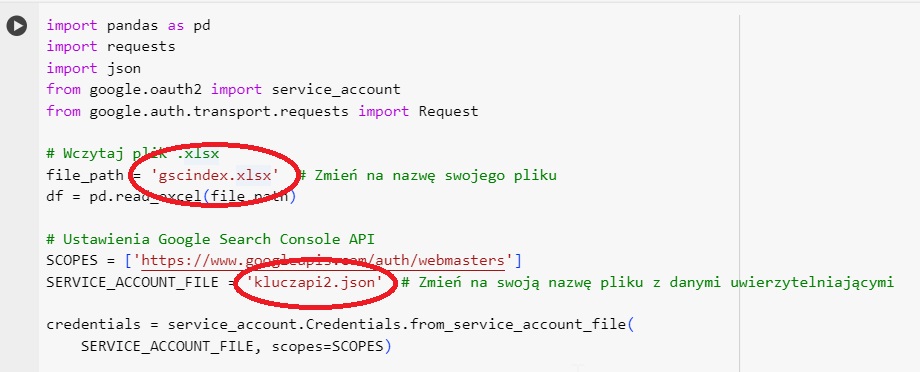

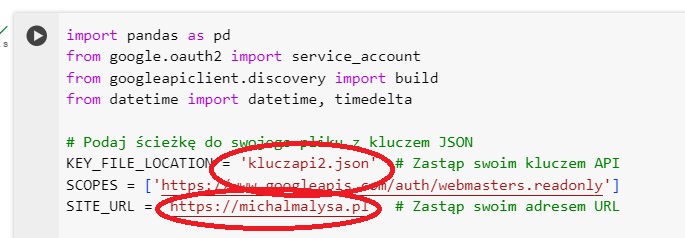

- Podmienić w kodzie nazwy swoich plików:

- Odpalić skrypt.

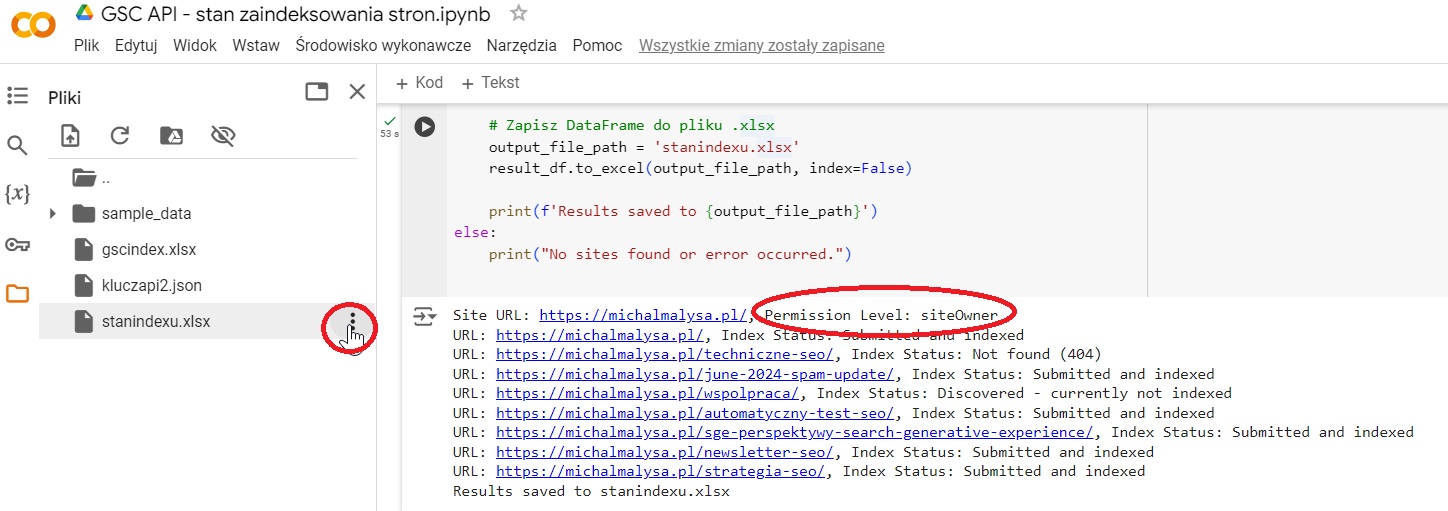

- Sprawdzić, czy skrypt ma dostęp do naszego GSC, a w przypadku sukcesu pobrać plik z wynikami.

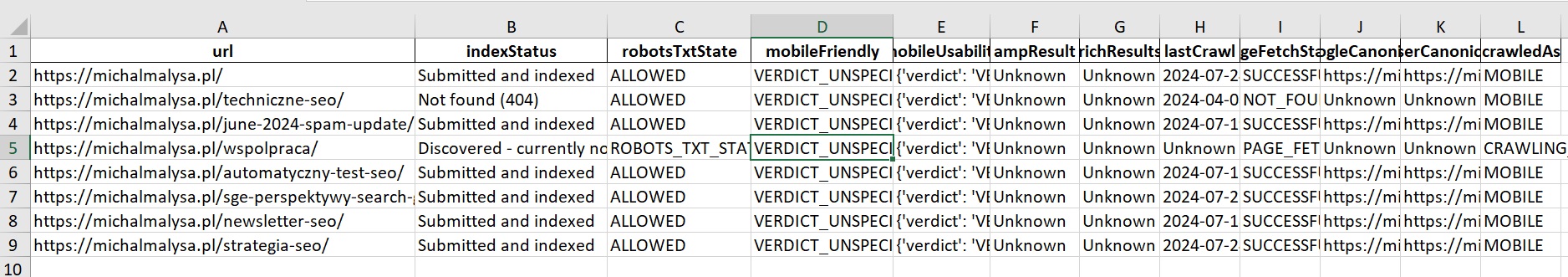

- Cieszyć się eleganckim sprawdzeniem indeksowania dla nawet 2000 adresów URL dziennie:

Sprawdzanie, dodawanie i usuwanie sitemap przez GSC API

Jednym z wdzięczniejszych sposobów na kontrolowanie poszczególnych grup adresów URL jest dodawanie ich do GSC w ramach osobnych sitemap, dzięki czemu dostajemy całkiem niezły raport dotyczący stanu ich zaindeksowania.

Specjaliści i specjalistki SEO korzystają z tej opcji dość często, chociaż w interfejsie GSC nie ma opcji masowego dodawania lub usuwania sitemap. Jeżeli dodajemy ich więcej lub chcemy zrobić porządek z już istniejącymi, czeka nas więc mozolna klikanina. Chyba że skorzystamy z GSC API.

Przygotowałem zestaw trzech skryptów pod zarządzanie sitemapami w GSC. Po skopiowaniu pliku Google Colab na swój Dysk Google w prosty sposób sprawdzisz wszystkie swoje sitemapy w GSC, masowo je dodasz lub usuniesz.

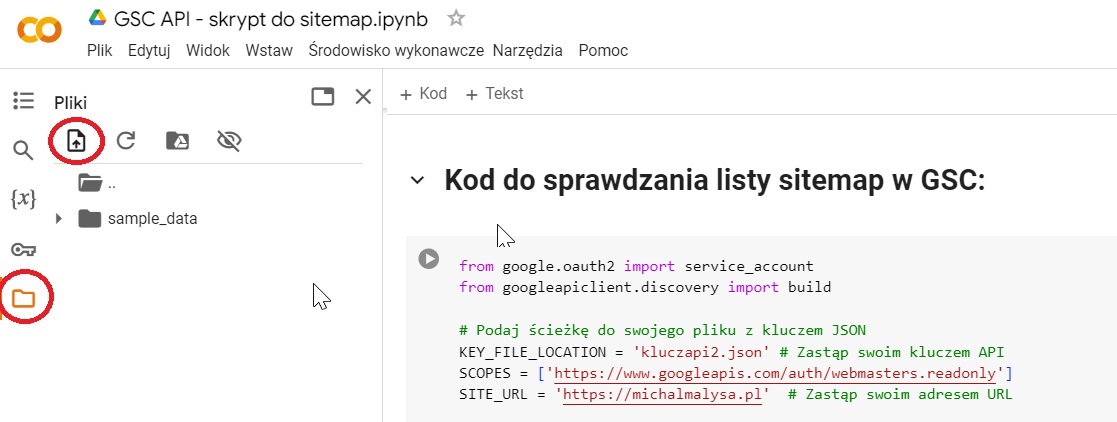

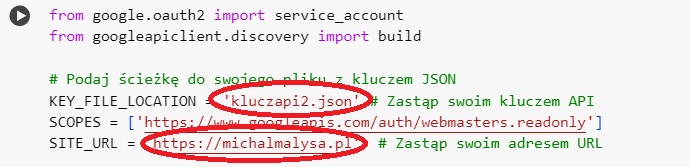

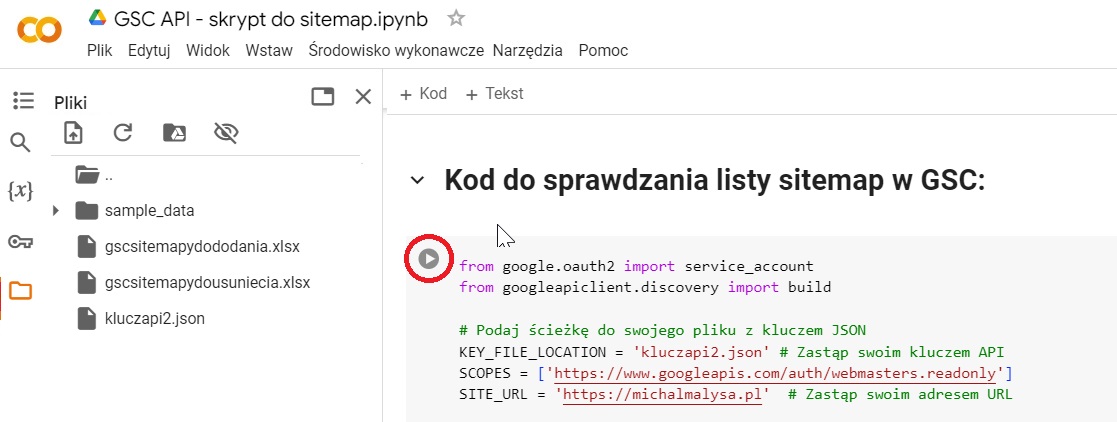

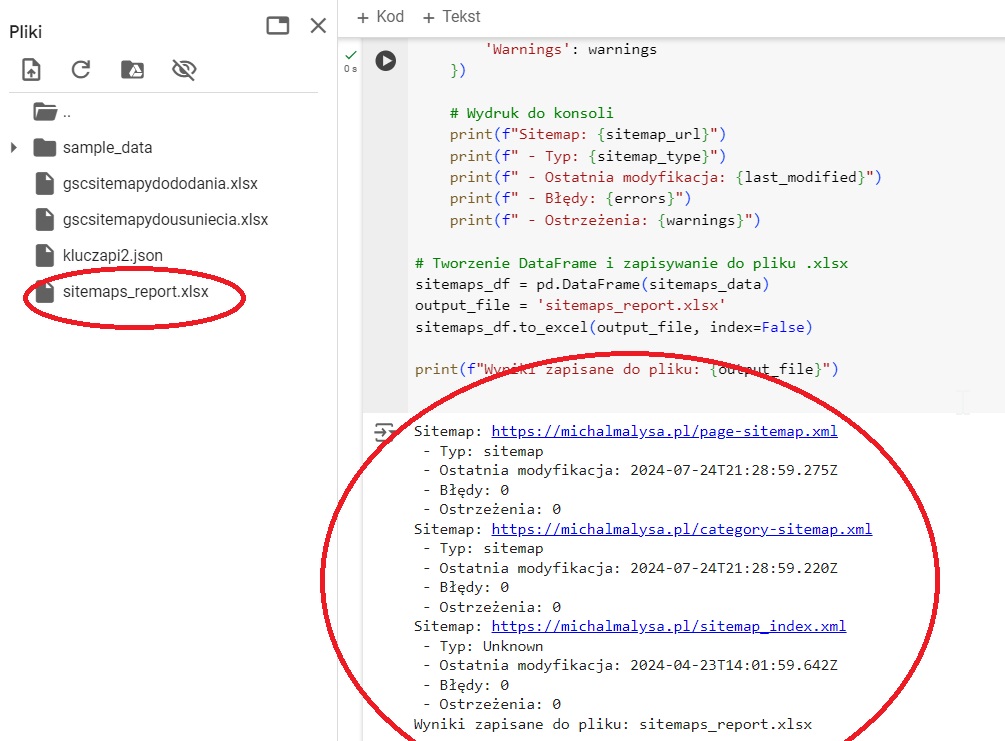

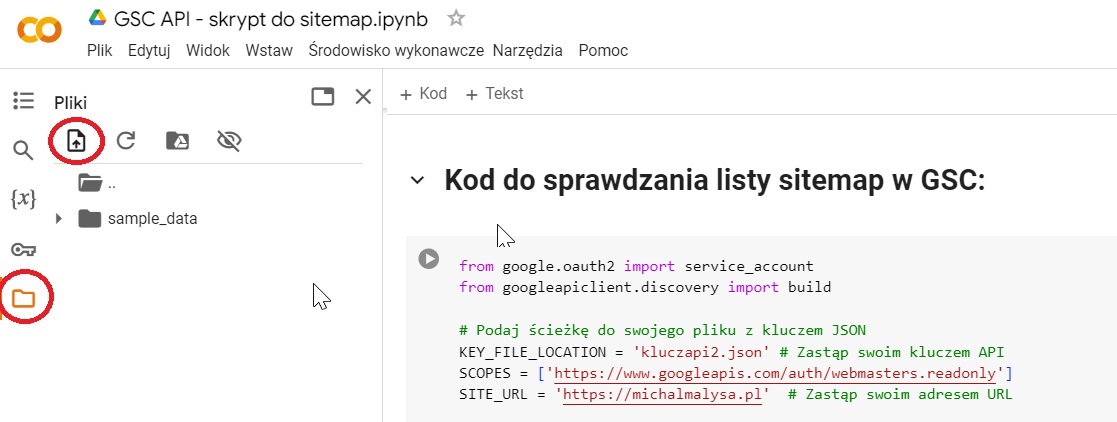

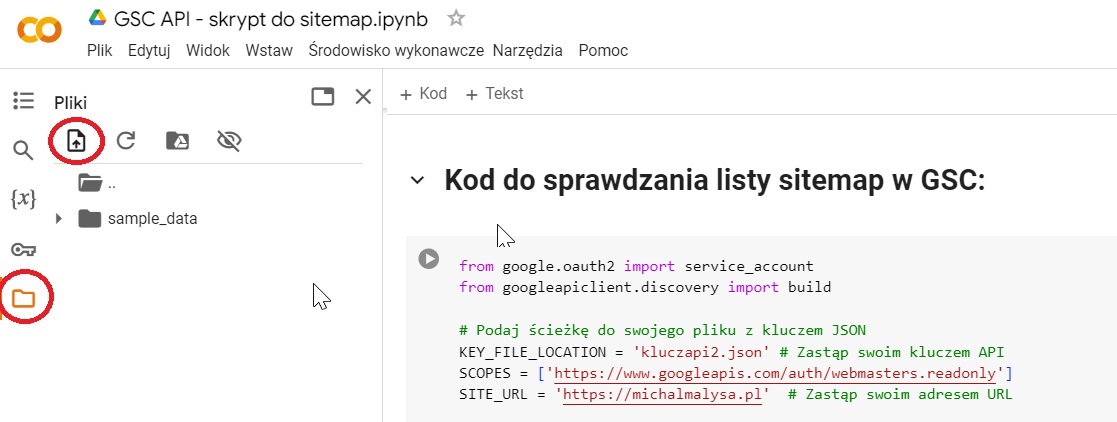

Aby sprawdzić sitemapy w GSC przez API:

- Dodaj klucz API do przestrzeni wirtualnej.

- Wpisz swoją nazwę pliku z kluczem API oraz swój adres domeny.

- Odpal skrypt.

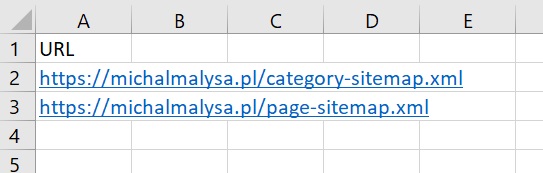

- Ciesz się z listy sitemap ze swojej usługi w GSC w konsoli oraz pliku Excel.

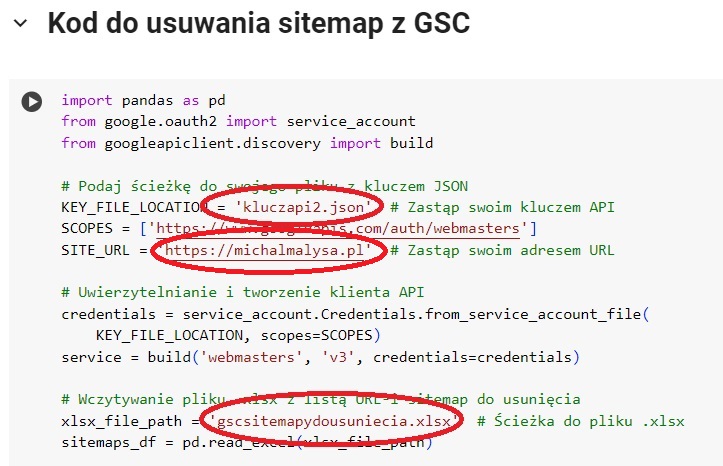

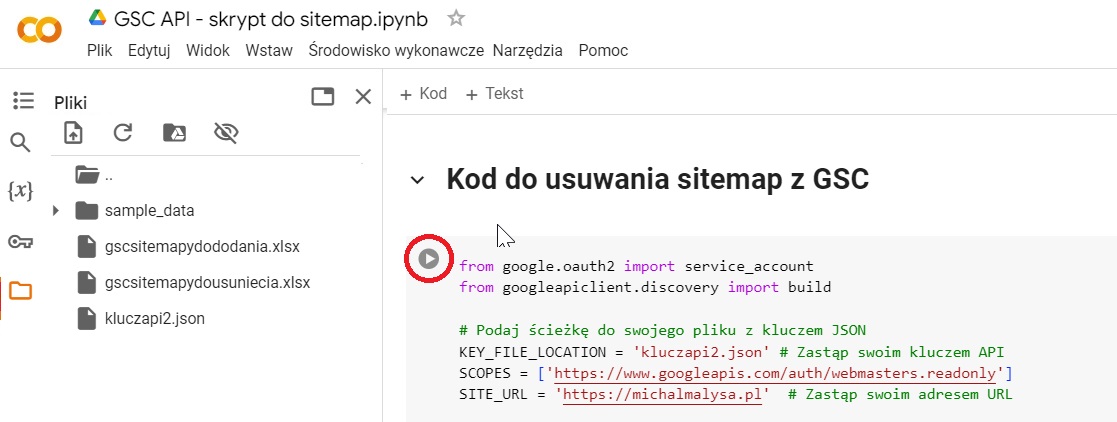

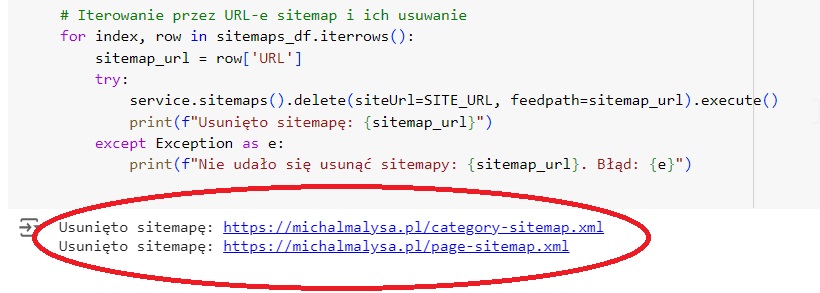

Aby usunąć masowo sitemapy w GSC przez API:

- Sporządź w pliku .xlsx listę adresów sitemap do usunięcia.

- Dodaj klucz API oraz plik z adresami sitemap do usunięcia do przestrzeni wirtualnej.

- Wpisz swoją nazwę pliku z kluczem API, swój adres domeny oraz swoją nazwę pliku z sitemapami do usunięcia.

- Odpal skrypt.

- Ciesz się z usuniętych sitemap (o ile chciałeś je usunąć, w innym przypadku możesz nie mieć powodu do radości).

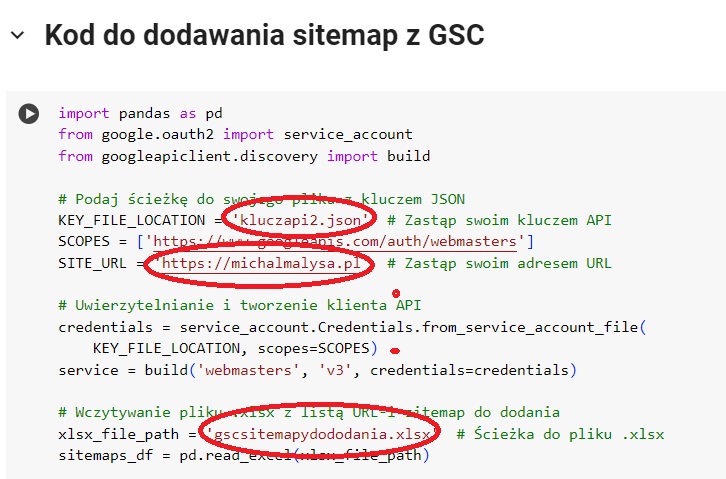

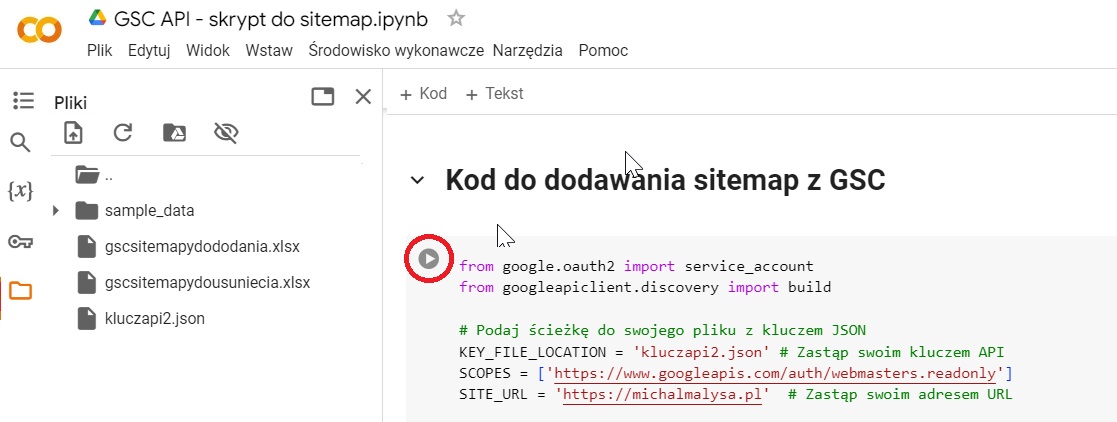

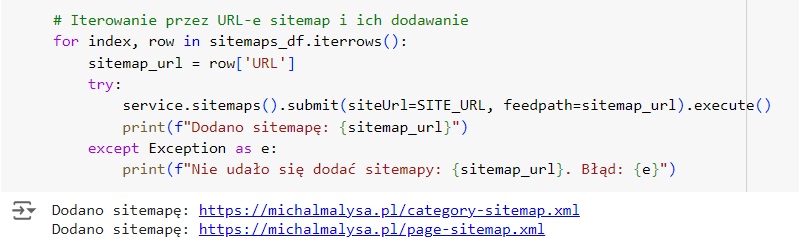

Aby dodać masowo sitemapy w GSC przez API:

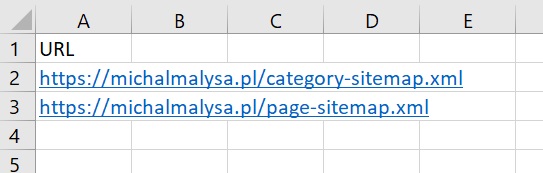

- Sporządź w pliku .xlsx listę adresów sitemap do dodania.

- Dodaj klucz API oraz plik z adresami sitemap do dodania do przestrzeni wirtualnej.

- Wpisz swoją nazwę pliku z kluczem API, swój adres domeny oraz swoją nazwę pliku z sitemapami do usunięcia.

- Odpal skrypt.

- Ciesz się z dodanych sitemap.

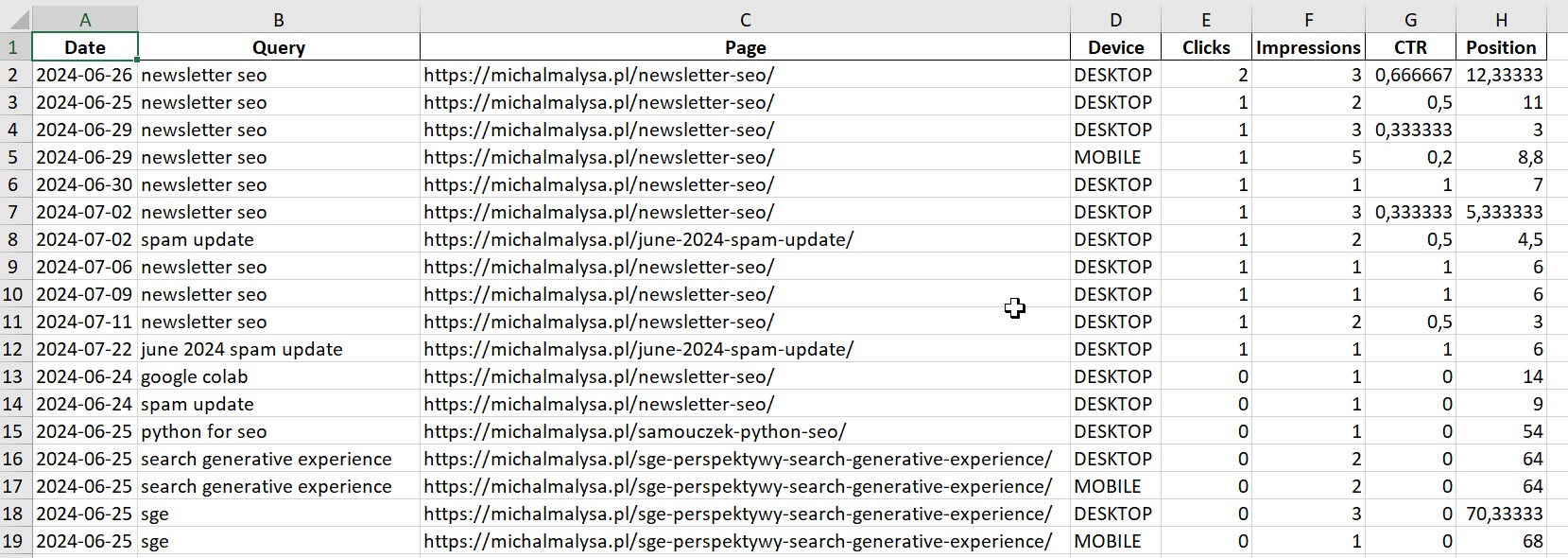

Pobieranie danych dotyczących skuteczności z GSC API

Wszelkie dane, które widzimy podczas połączenia GSC z Looker Studio, możemy wyciągnąć również przez API. Niestety, stworzenie jednego uniwersalnego skryptu jest w tym przypadku niemożliwe - wśród seowczyń i seowców zaistnieć może tyle potrzeb do wyciągnięcia konkretnych informacji, ile wymiarów dostępnych jest w API GSC.

Z tego względu prezentuję w tym miejscu sposób na wyciągnięcie najprostszych danych i zachęcę do modyfikowania zapytań według własnego uznania, do czego użyć należy oczywiście ChataGPT. Sensowne pomysły na requesty (Top X zapytań, Top X podstron, zapytania sekwencjonujące dane w celu ominięcia limitu 25 000 wierszy) znajdują się również w dwóch przewodnikach Google: tutaj i tutaj.

Podobnie jest z grupowaniem i wizualizacją danych - w tym przypadku również polecam skorzystać z prostych promptów, które przygotują odpowiedni kod do przetwarzania data frames oraz tworzenia wykresów z bibliotekami matplotlib czy seaborn. Chociaż istnieje duża szansa, że zdecydowaną większość waszych potrzeb raportowo-analitycznych sprawniej zaspokoi Looker Studio.

Aby wyciągnąć dane dotyczące skuteczności z GSC API, należy:

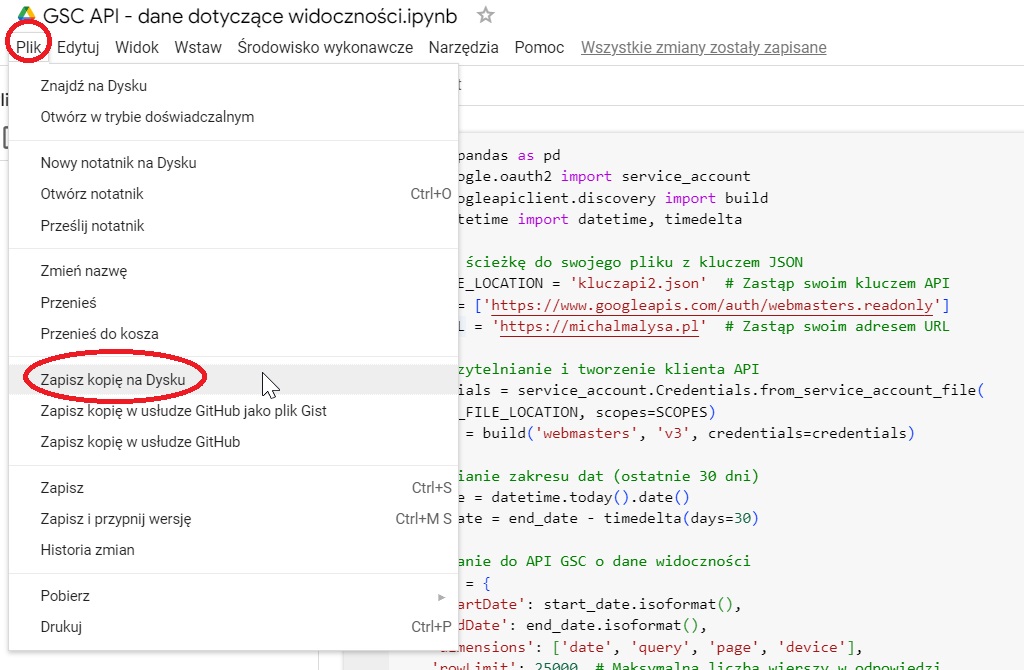

- Skopiować skrypt do wyciągania danych widoczności przez GSC API na swój Dysk Google.

- Dodać klucz API do przestrzeni wirtualnej.

- Wpisać swoją nazwę pliku z kluczem API oraz swoją nazwę domeny.

- Odpalić kod.

- Cieszyć się eleganckimi danymi wyeksportowanymi do Excela.

Jak widzicie, na tak świeżym blogu szczątkowy ruch przynosi wyłącznie podstrona z newsletterem SEO 😉

Eksport danych z GSC przez BigQuery

Opcją uznawaną powszechnie za najbardziej stabilną w wyciąganiu maksymalnych wolumenów danych z GSC jest eksport wszelkich dostępnych informacji za pośrednictwem BigQuery. Polecają ją również oficjalne rekomendacje GSC.

Przechowywanie informacji w hurtowni danych ma również tę zaletę, iż pozwala na ominięcie jednego z najbardziej irytujących ograniczeń GSC, czyli dostępu do statystyk sięgających maksymalnie 16 miesięcy wstecz. Rozwiązanie to wiąże się jednak z koniecznością zaangażowania niemałych zasobów.

O ile samo odkładanie danych nie stanowi problemu i generuje koszty dopiero w przypadku naprawdę dużych serwisów, tak bardzo szybko polecieć można na odpytywaniu BigQuery. To standardowo pułapka pracy z big data — w przypadku mniejszych biznesów zasoby poświęcone na pozyskanie i procesowanie danych są niewspółmierne do zysków, natomiast większe podmioty muszą solidnie napracować się nad optymalizacją kosztów.

Trzy wcześniejsze sposoby na pozyskanie znacznie dokładniejszych danych z Google Search Console nie są problematyczne i leżą w zasięgu wszystkich specjalistek i specjalistów SEO. Wdrożenie rozwiązań opartych na BigQuery wymaga natomiast znacznie większych kompetencji technicznych. To olbrzymi projekt, który zakłada co najmniej trzy etapy:

- Względnie proste wdrożenie odkładania danych z GSC do BigQuery, które krok po kroku opisane zostało w Help Center GSC.

- Znalezienie sposobu na optymalne kosztowo i czasowo przetwarzanie odłożonych danych. O tym, jak skomplikowany i wymagający jest to proces, możecie przekonać się poprzez lekturę tego wpisu na blogu ClickHouse.

- Poświęcenie czasu na opracowanie sposobu wizualizacji danych oraz wyciągania z nich insightów. To mój absolutnie ulubiony aspekt pracy z dokładnymi danymi z GSC, jednak niewątpliwie czasochłonny.

Ze względu na powyższe uwarunkowania łączenie GSC z BigQuery jest rozwiązaniem dla dużych organizacji, które mają odpowiednie kompetencje i są w stanie poświęcić kilkadziesiąt roboczogodzin, aby pozyskać duże wolumeny danych i zrobić z nich odpowiedni użytek.

Odpowiedź na cisnące się na usta pytanie, czy jest to opłacalne, musi zostać udzielona na poziomie organizacyjnym. Często wiąże się z pytaniem, czy dane dotyczące ruchu z Google'a wpływają na podejmowane działania SEO i/lub są podstawą decyzji strategicznych, czy może stanowią czynnik trzeciorzędny, a co za tym idzie - czy ich pozyskiwanie nie będzie przepalaniem zasobów.