Natural Language API jest tą usługą z Google Cloud, która na papierze wygląda na najbardziej obiecującą, a w praktyce jej użyteczność dla specjalistek i specjalistów SEO w Polsce jest co najmniej dyskusyjna. Wszystko przez fakt, że nie obsługuje tekstów w języku polskim. Dzięki możliwości automatycznego tłumaczenia tekstów i faktowi, że nie będą to treści przeznaczone dla użytkowniczek i użytkowników, coś z Natural Language API jesteśmy jednak w stanie wyciągnąć. Pokazuję, jak to zrobić.

Co to jest Natural Language API?

Natural Language API to usługa oferowana w ramach Google Cloud. Umożliwia analizę tekstów pisanych w języku naturalnym. API to wykorzystuje zaawansowane modele uczenia maszynowego i przetwarzania języka naturalnego (NLP), aby automatycznie analizować i rozumieć tekst.

W Natural Language API możemy:

- Przeprowadzać analizę sentymentu (Sentiment Analysis). Umożliwia to ocenę emocjonalnego tonu tekstu i określenie, czy jest on pozytywny, negatywny, czy neutralny.

- Automatycznie rozpoznawać encje nazwane (Named Entities Recognition). Natural Language API wykrywa i klasyfikuje encje nazwane w tekście. Do tego rodzaju jednostek należą osoby, miejsca, organizacje, daty itp.

- Dokonywać analizy składni (Syntax Analysis). API analizuje strukturę składniową zdań, identyfikując części mowy (rzeczowniki, czasowniki, przymiotniki itp.) oraz zależności między słowami.

- Kategoryzować treści (Content Classification). Sprawdzić, w jaki sposób systemy zbliżone w jakimś stopniu do algorytmów Google'a przypisują treści do określonych kategorii tematycznych.

Jak wspomniałem we wstępie, Natural Language API nie obsługuje języka polskiego, co znacząco ogranicza użyteczność tego narzędzia. Python oferuje kilka fantastycznych bibliotek, które są w stanie obsługiwać język polski i dzięki temu skuteczniej analizować składnię czy rozpoznawać więcej encji nazwanych.

Jeżeli mamy jednak dużą bazę tekstów, którą chcemy przeanalizować pod względem popularności bardzo ogólnikowych encji w konkretnych okresach czy w prosty sposób skategoryzować treść, Natural Language API wsparty o wcześniejsze automatyczne tłumaczenie posłuży do tego idealnie. A przynajmniej dopóki, dopóty nie skończą nam się darmowe środki w Google Cloud — jest to narzędzie w pełni płatne i raczej nie polecałbym nikomu płacić za coś, co nie jest w pełni użyteczne.

Jak uzyskać dostęp do Natural Language API?

Uzyskanie dostępu do Natural Language API i pobranie danych uwierzytelniających wygląda identycznie jak w przypadku uzyskiwania dostępu do GSC API. Aby móc korzystać z tej usługi, należy:

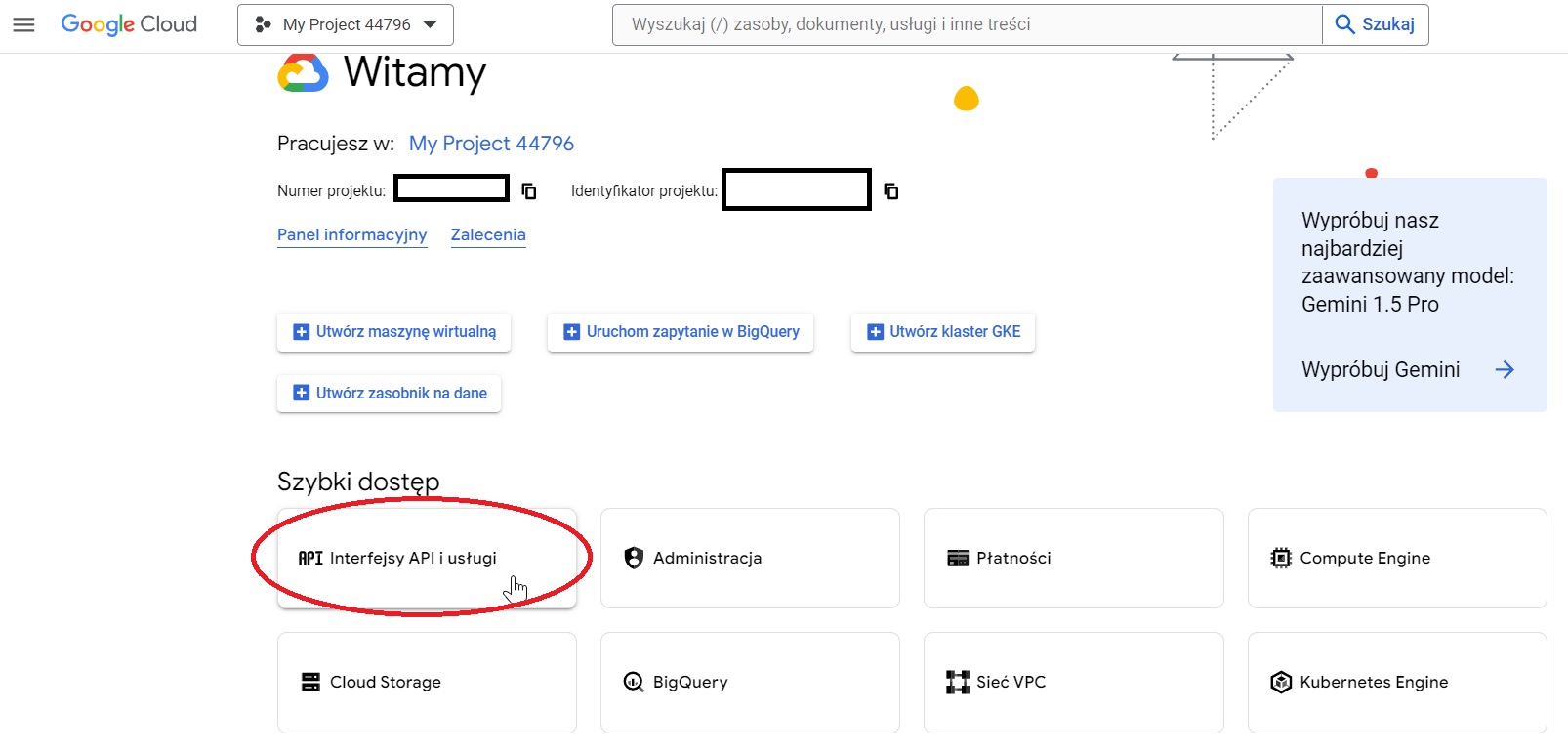

- W otwartym projekcie w konsoli Google Cloud kliknąć w "Interfejsy API i usługi".

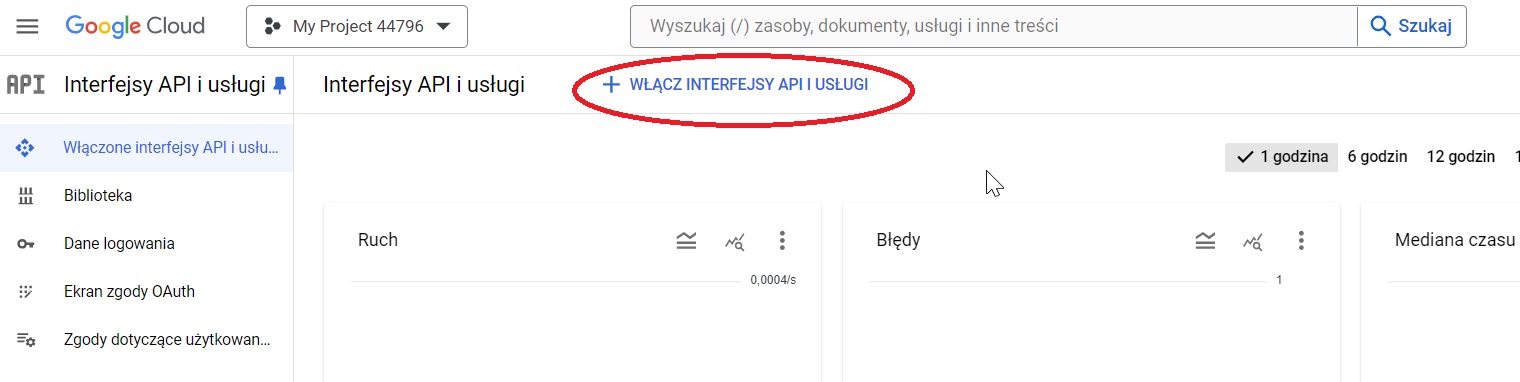

- Kliknąć "Włącz interfejsy API i usługi".

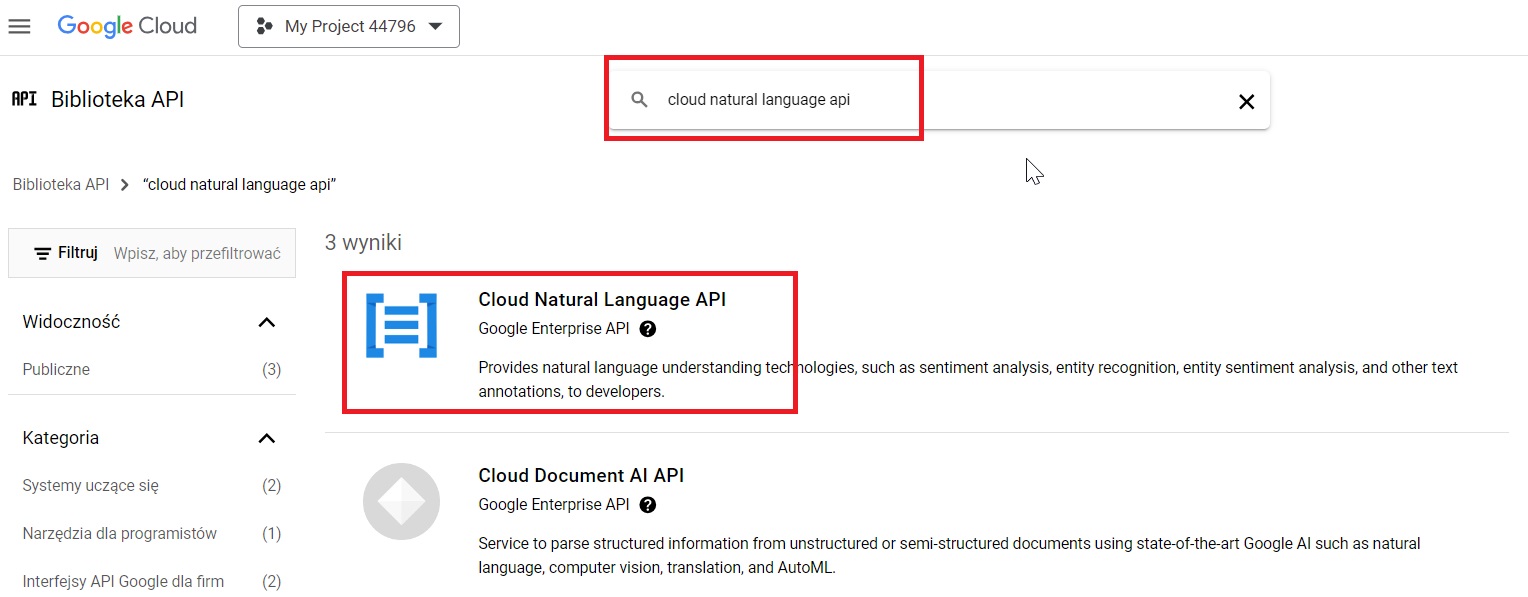

- Wpisać w wyszukiwarkę "natural language api" i kliknąć w wynik.

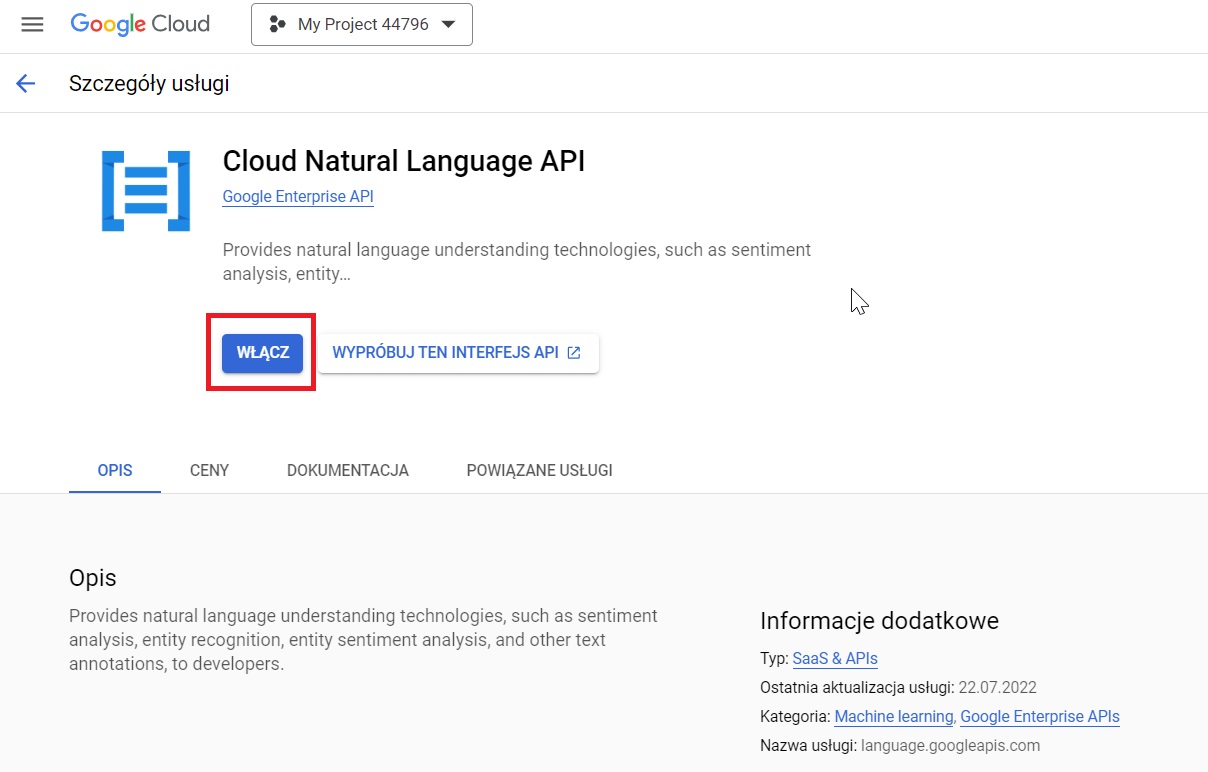

- W szczegółach usługi kliknąć "Włącz".

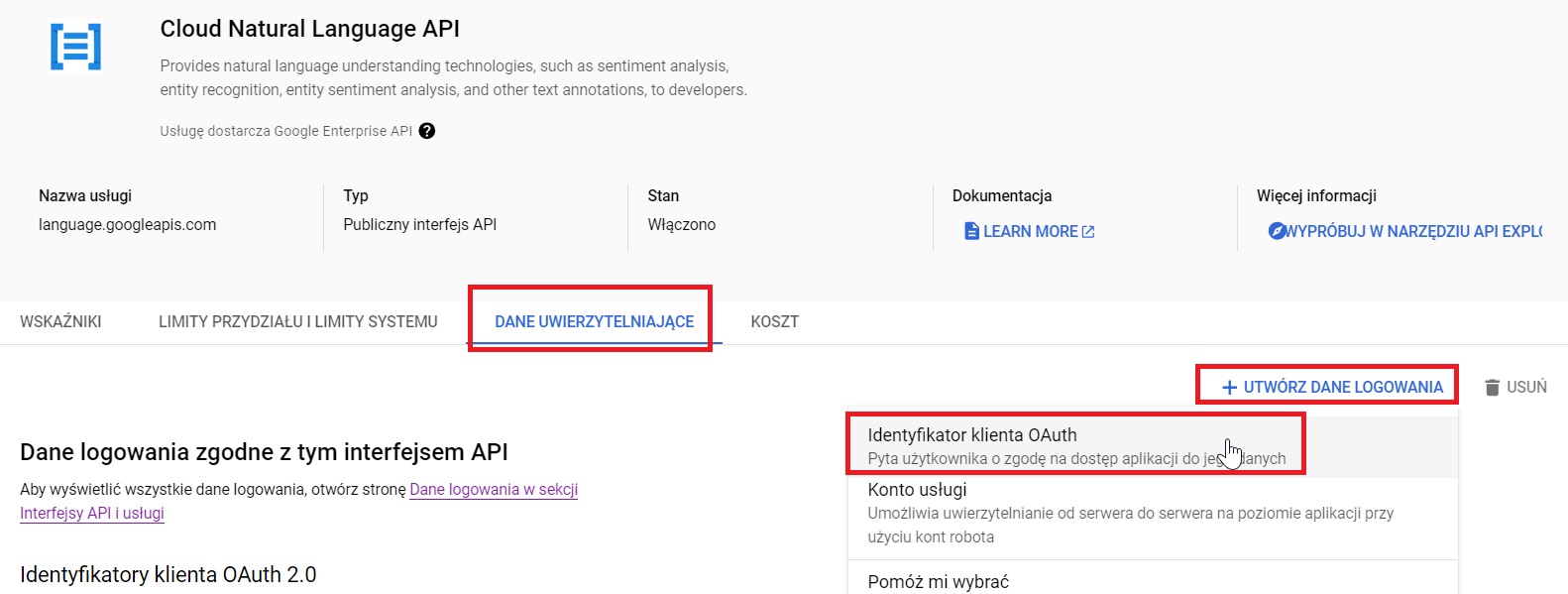

- Jeżeli nie tworzyliśmy wcześniej kont usługi w Google Cloud, wybrać zakładkę "Dane uwierzytelniające" i po rozwinięciu opcji "Utwórz dane logowania" wybrać "Identyfikator klienta OAuth".

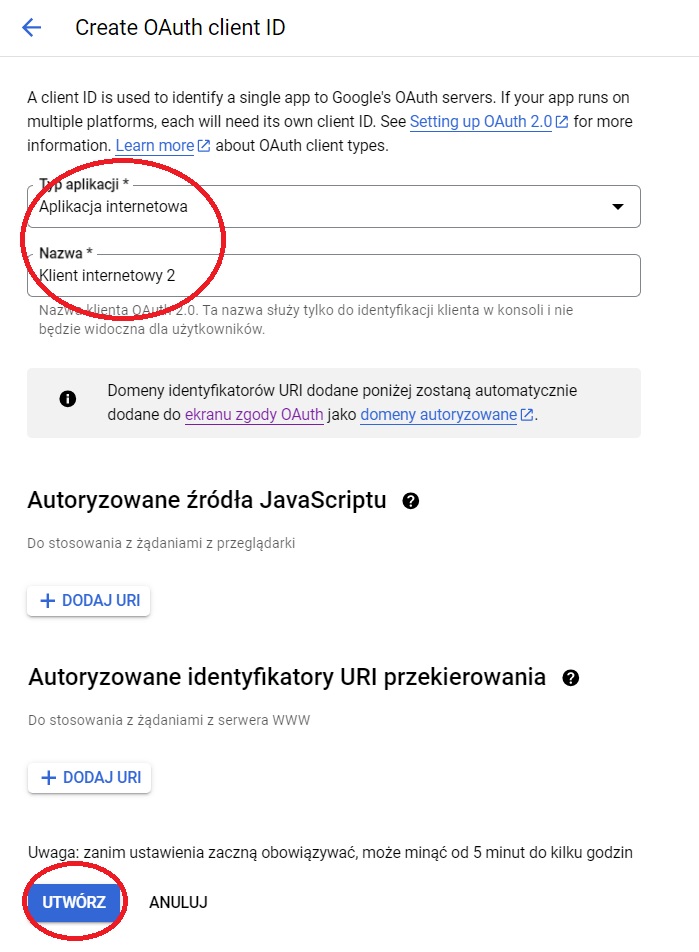

- Wybrać wartości dla "Typ aplikacji" oraz "Nazwa" i kliknąć "Utwórz".

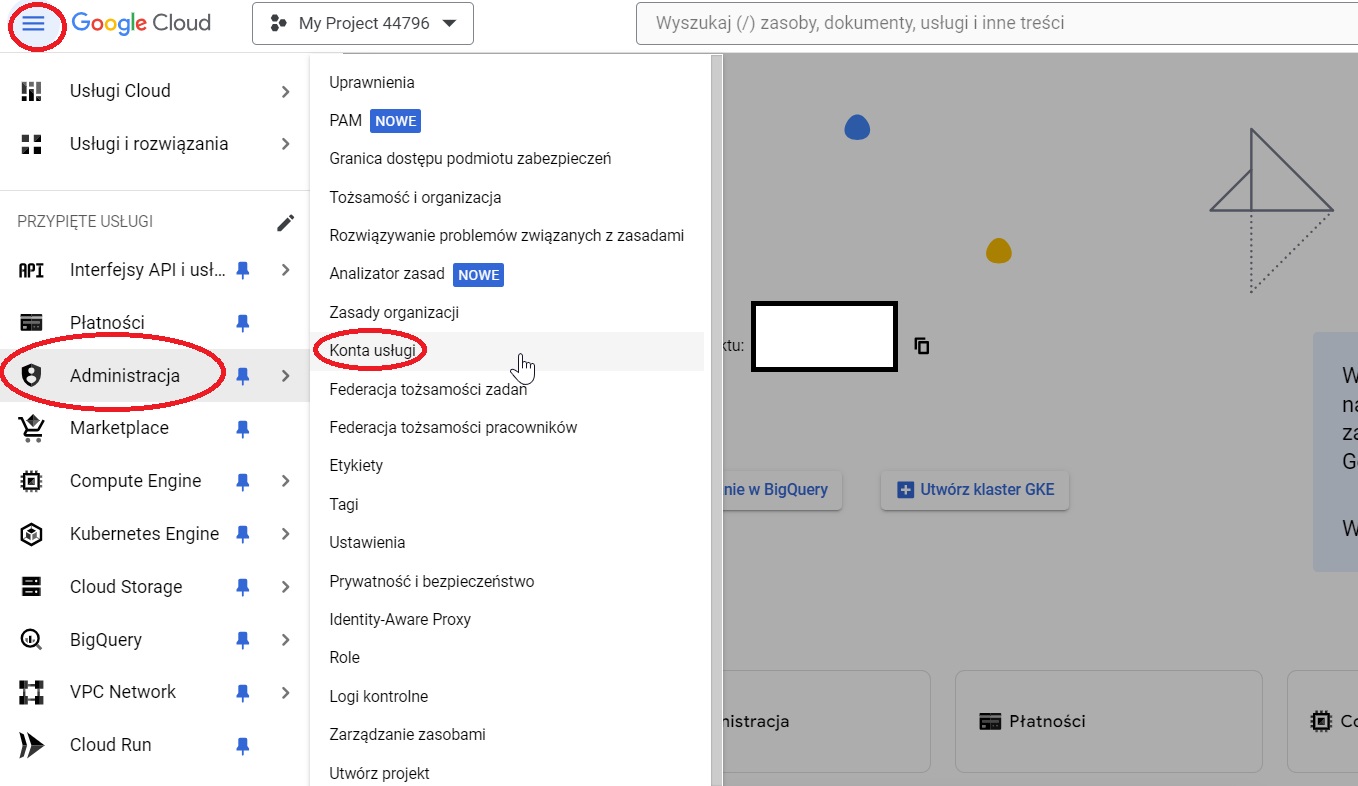

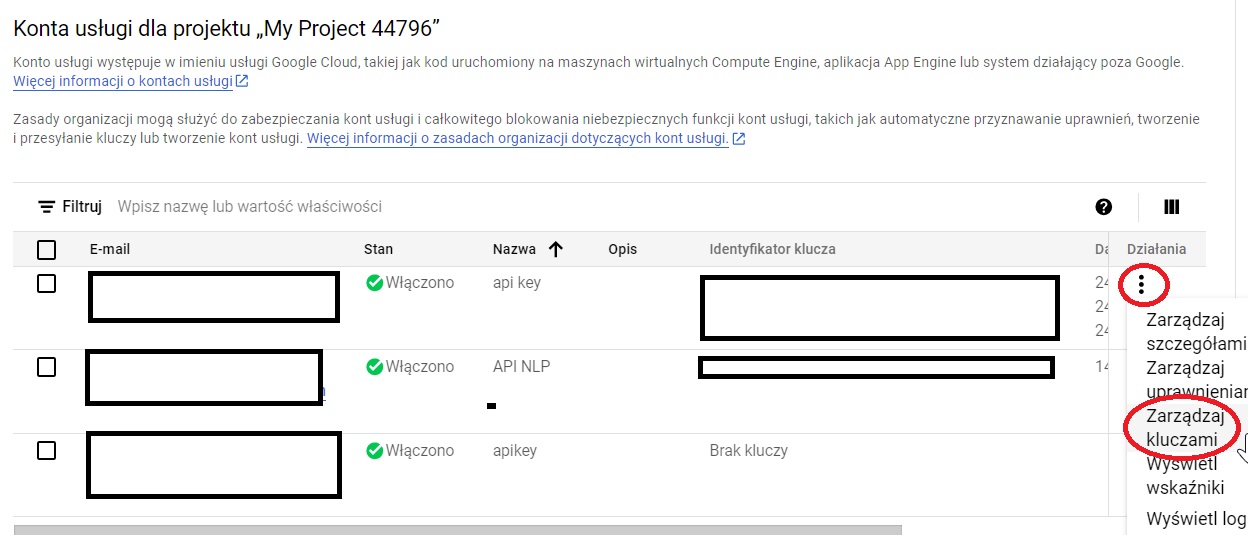

- Jeżeli utworzyliśmy identyfikator lub mieliśmy go wcześniej, w panelu projektu kliknąć hamburger z ustawieniami, tam rozwinąć zakładkę "Administracja" i kliknąć "Konta usługi".

- W panelu "Konta usługi" rozwinąć trzy kropeczki z kolumny "Działania" i kliknąć "Zarządzaj kluczami".

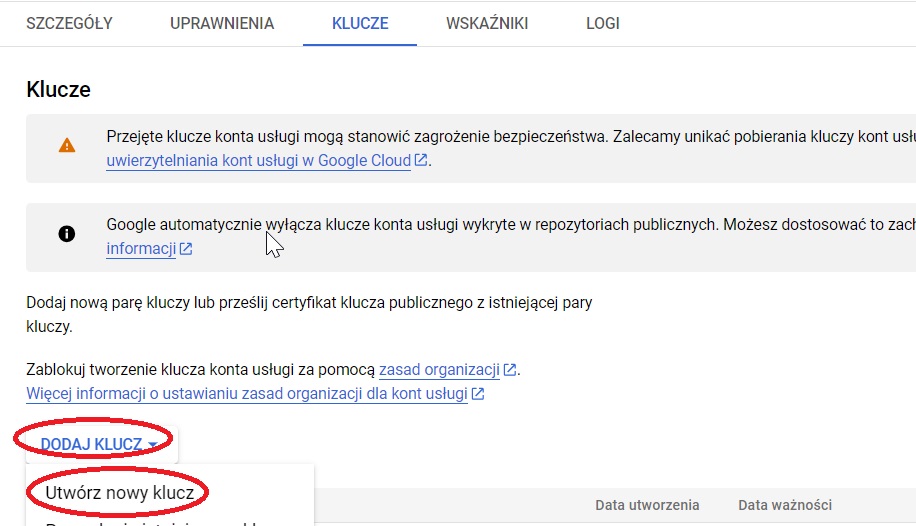

- Jeżeli nie mamy pobranego klucza, w panelu zarządzania kluczami rozwinąć opcję "Dodaj klucz" i kliknąć "Utwórz nowy klucz".

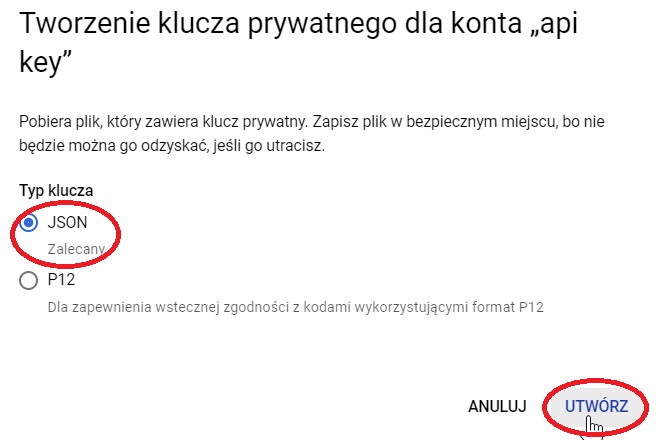

- W okienku, które wyskoczy, wybrać opcję "JSON" i kliknąć "Utwórz".

- Zapisać klucz pod zrozumiałą nazwą (np. "kluczapi").

Posiadając dane uwierzytelniające w pliku JSON, możemy przejść do analizy NLP.

Prosty skrypt do Natural Language API

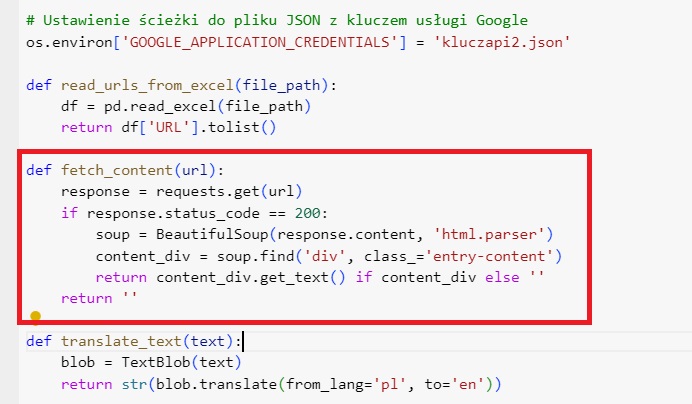

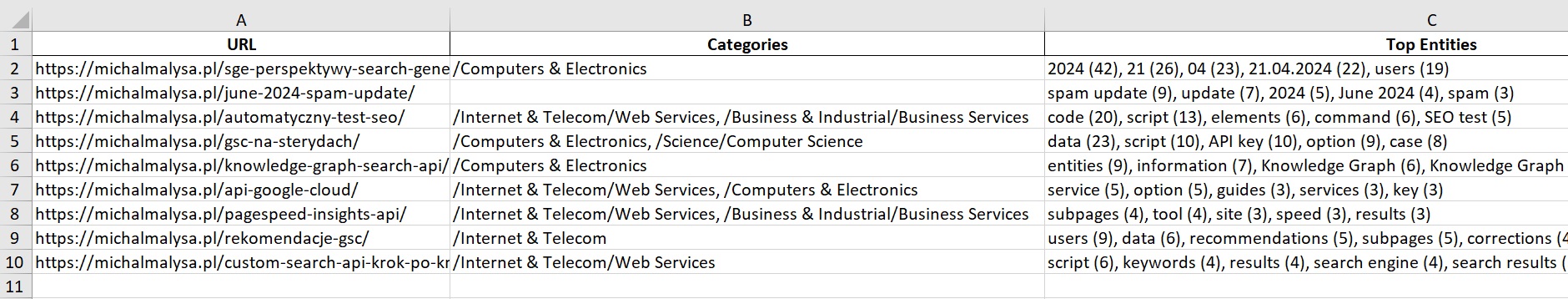

Standardowo dla moich poradników skorzystamy z Pythona. Przykładowy skrypt wyciągnie treść ze wskazanych adresów URL (co ułatwia fakt, że znajduje się ona w obrębie divu z określoną klasą 'entry-content'; w przypadkach bardziej urozmaiconych stron trzeba sobie pomóc wykluczeniami określonych elementów, w czym w pełni pomaga ChatGPT), przetłumaczy ją na język angielski, a następnie przy pomocy Natural Language API wskaże kategorie oraz najpopularniejsze encje.

Aby skorzystać w ten sposób z Natural Language API, skorzystaj z poniższej instrukcji:

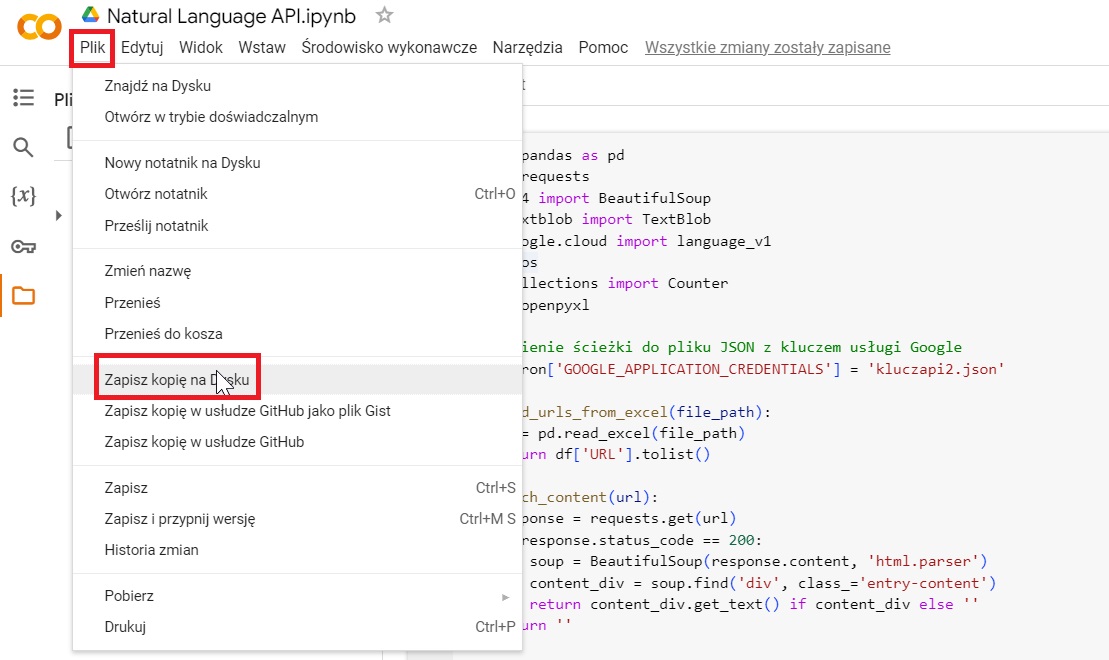

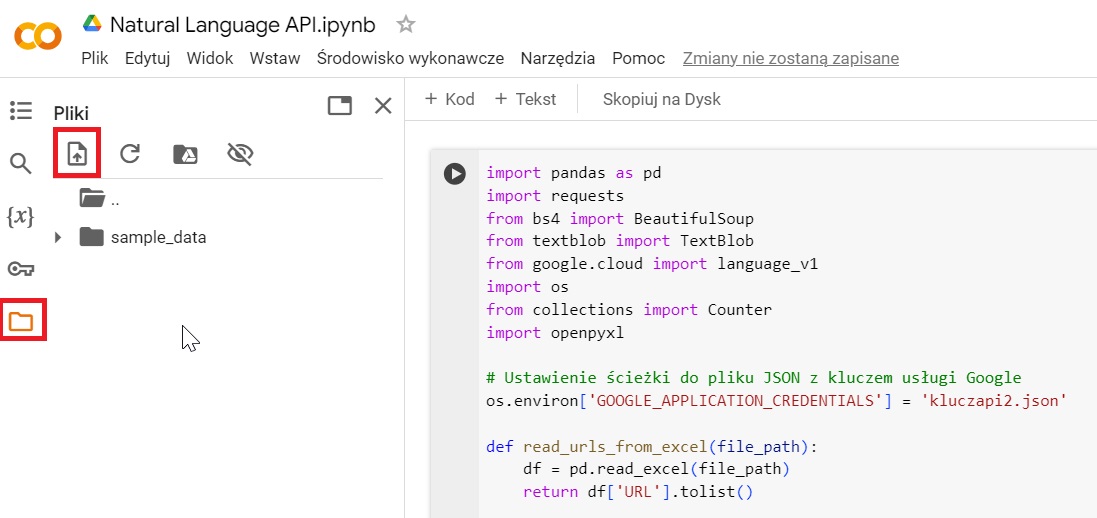

- Otwórz przygotowany przeze mnie skrypt Natural Language API w Google Colab.

- Skopiuj skrypt na swój dysk Google.

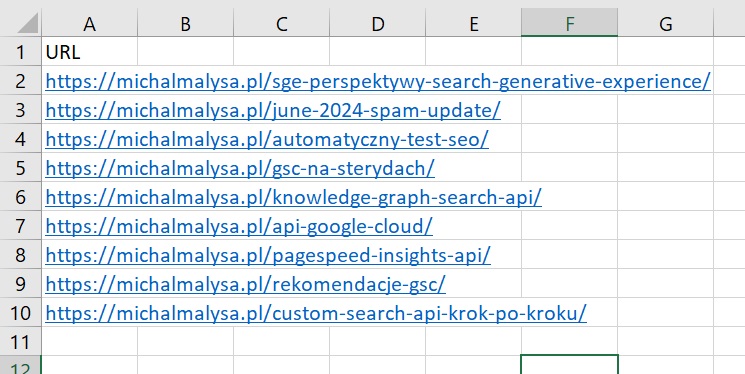

- Przygotuj plik Excel z adresami URL do przeanalizowania w kolumnie "URL".

- Wczytaj plik Excel z adresami URL do pamięci wirtualnej Google Colab.

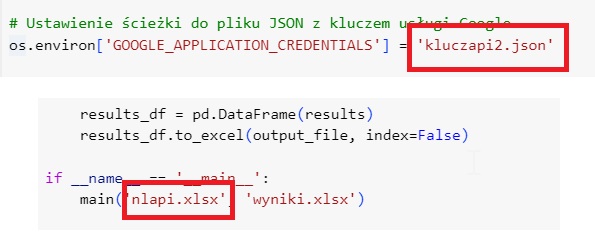

- Uzupełnij fragmenty kodu związane z nazwami wczytanych wcześniej plików.

- Przystosuj funkcję fetch_content przy pomocy ChataGPT i kodu strony, którą analizujesz.

- Odpal kod i sprawdź wyniki w konsoli oraz wynikowym pliku Excela.

Jak widać, na małej próbce danych nie wygląda to szczególnie imponująco. Podobnie jak w przypadku prezentowanego przeze mnie poradnika Custom Search API, i tutaj nie mamy do czynienia z prostym i uniwersalnym narzędziem typu ZNALAZŁ JEDEN PROSTY SPOSÓB, AGENCJE SEO GO NIENAWIDZĄ. Umiejętność wykorzystywania API jest przydatna dlatego, że możemy wykorzystywać ją w pracy nad przypadkami szczególnymi, dostosowując kod do konkretnych potrzeb.

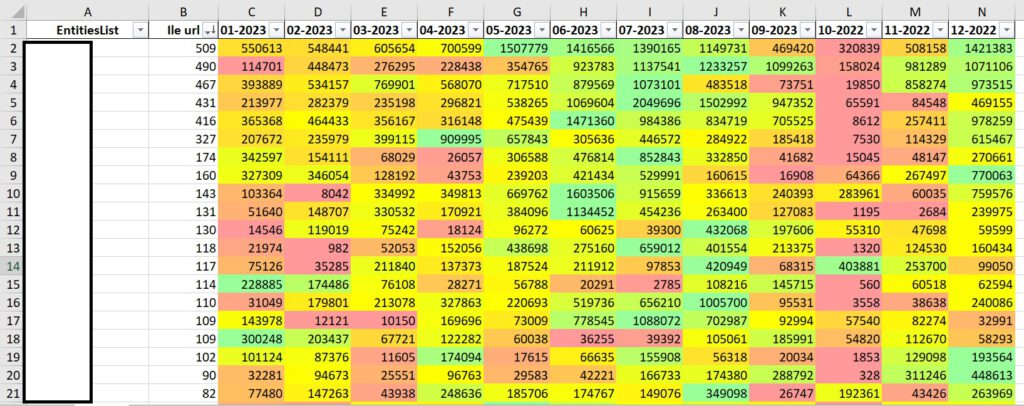

Dostosowywanie kodu do indywidualnych potrzeb jest oczywiście kwestią podziałania z promptami w ChacieGPT. Po ustaleniu odpowiedniej metodologii (co nie jest wcale takie proste) możemy chociażby zobaczyć w dużej skali wyniki uzyskiwane przez konkretne encje na przestrzeni roku. Co istotne, widoczne poniżej liczby nie odpowiadają żadnej konkretnej metryce takiej jak wyświetlenia czy kliknięcia, to połączenie punktów ważonych za różne elementy performance'u tekstów oraz stopień obecności danej encji w tekście.